Consultation, citoyenneté, démocratie, financement, habitat, art, culture, chantier… ces dernières années, le « participatif » se conjugue à tous les modes ! Conséquence plus ou moins directe de la révolution numérique qui bouleverse notre capacité d’information en nous y offrant un accès illimité, cette dynamique participative est le témoin d’une volonté diffuse mais manifeste de renversement des processus de décision concernant l’intérêt général, pensé comme une construction collective, par la réappropriation des outils du vivre-ensemble. L’ambition de participer n’est pas une utopie dans le monde de la belle idée : elle s’applique dans des fonctionnements très concrets, qui peuvent, comme les expériences le montrent, s’installer à toutes les échelles, y compris celle de l’école !

Comme nous le rappelle la philosophe Joëlle Zask dans son article, « Apprendre à participer, participer pour apprendre » (p. 51), John Dewey avait déjà souligné l’importance cruciale de l’expérience, de la participation dans les apprentissages en ce qu’ils mobilisent la conscience et placent l’apprenant dans une posture active. Et, si « une approche sociale des intelligences collectives et participatives est devenue prioritaire chez les acteurs de l’école, des apprentissages » comme le soulignent Anne Cordier et Vincent Liquète (p. 12), le lien ténu entre participation et information semble naturellement faire du professeur documentaliste la pierre angulaire de cette articulation au sein des établissements.

Relisons la circulaire de missions à cette lumière, qui replace le professeur documentaliste au cœur de « l’équipe pédagogique » dont il partage les « missions communes » et anime les « co-enseignements ». Ses missions spécifiques en font par ailleurs un « acteur de l’ouverture de l’établissement sur son environnement éducatif, culturel et professionnel (…) en lien avec les dispositifs pédagogiques et éducatifs mis en place dans l’établissement, dans et hors du CDI ». Le professeur documentaliste se trouve ainsi posé en véritable maître d’œuvre d’une « pédagogie favorisant l’autonomie, l’initiative et le travail collaboratif des élèves, autant que la personnalisation des apprentissages, l’interdisciplinarité et l’usage des technologies de l’information et de la communication » dont le but est de « rendre l’élève acteur de ses apprentissages ».

Les nombreuses réponses que nous avons reçues suite à notre appel à contributions prouvent bien à quel point vous êtes, nous sommes engagés dans ces dynamiques. À la fois en tant qu’acteur à l’initiative de projets plus riches les uns que les autres – CDI-

remix (p. 21), juniors associations (p. 24), élève médiateur (p. 41) – mais aussi dans une réflexion plus globale sur le rôle d’enseignant qu’elles tendent à redéfinir, et qu’il ne s’agit pas pour autant de bazarder aux sirènes de la démagogie ! (p. 29 et 46)

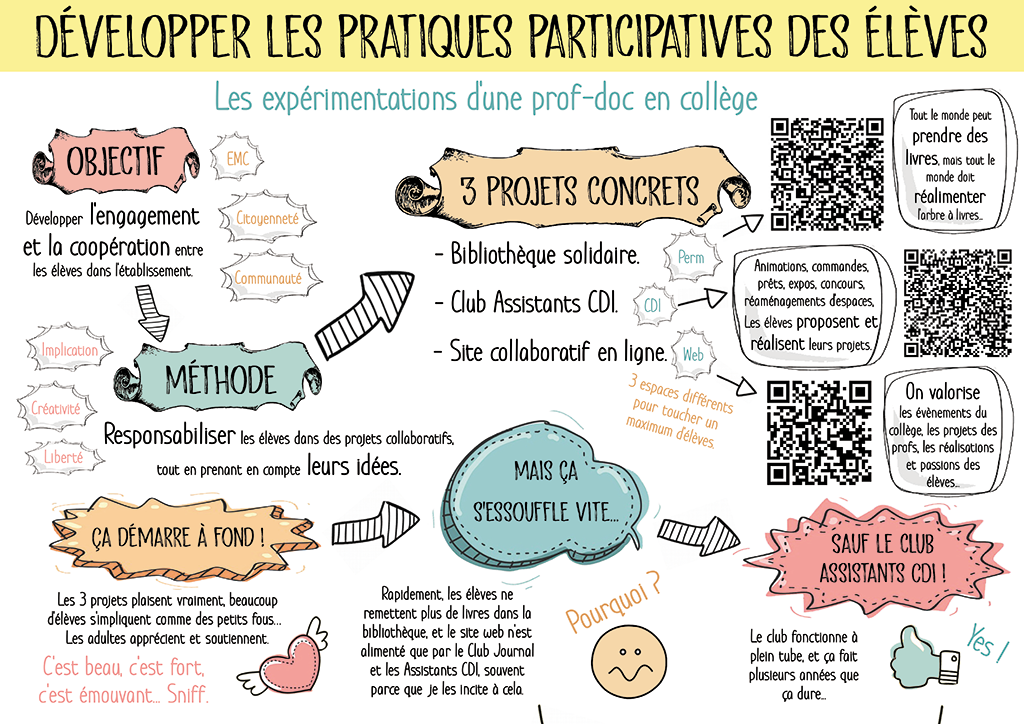

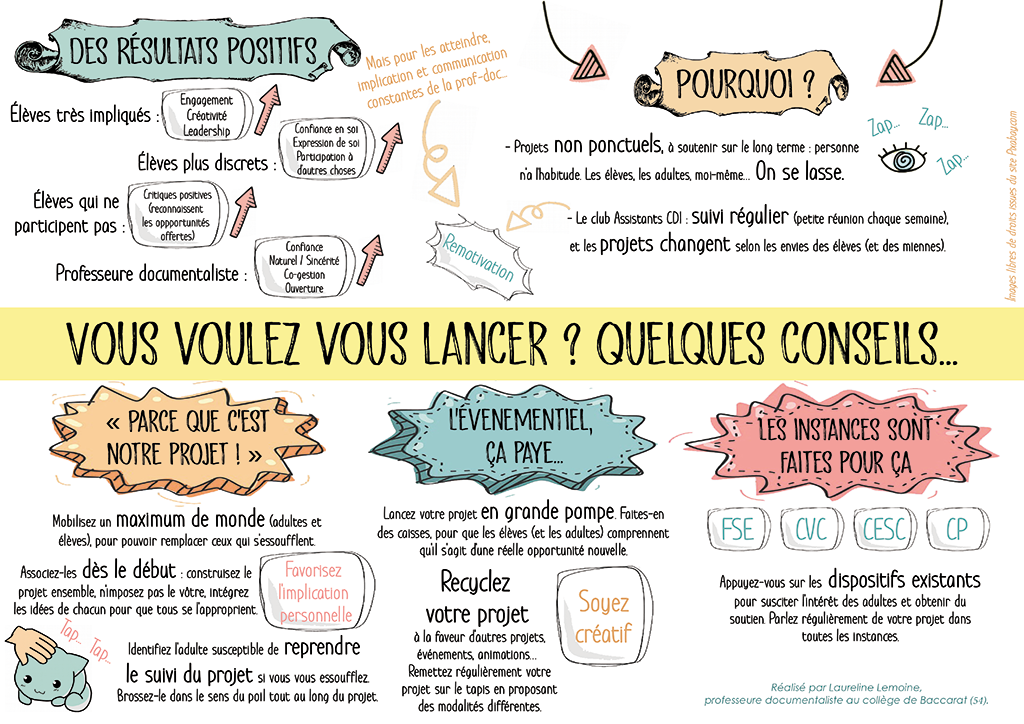

C’est toute cette complexité que ce dossier explore afin de partager avec vous les idées, les enthousiasmes, les réussites, mais aussi les doutes et les limites qui bordent la mise en œuvre de ces pratiques participatives favorisant l’horizontalité des interactions. Nous remercions vivement l’ensemble des contributeurs qui nous ont généreusement livré le fruit de leur travail, y compris des outils clés en main comme la fiche Intercdi « mettre en place une give-box » ou le Sketchnote « développer les pratiques participatives des élèves » pour vous les proposer.

Bien entendu, nous comptons sur votre participation à un prochain numéro de votre revue. Bonne lecture !

Légendes urbaines de la documentation

La légende, c’est cette histoire qui se doit d’être transmise au fil des générations car elle est porteuse d’enseignements. Étymologiquement, legenda désigne ce qui doit être lu, ce qui en fait un document à part entière, au sens « de leçon de vie » si on reprend l’étymologie du mot documentum proposée par le Gaffiot. Ce sont des histoires que l’on se raconte sans trop savoir si elles se sont réellement produites, mais qui paraissent d’autant plus crédibles qu’il nous semble que c’est quelqu’un de proche qui nous l’a racontée…

De telles histoires existent dans nos domaines. Il y a par exemple l’histoire de cette jeune fille, poignardée dans une bibliothèque sans que personne ne s’en aperçoive, le meurtrier ayant pu ressortir totalement incognito sans être inquiété. Le corps de l’étudiante n’est découvert que quelques minutes plus tard, mais il est hélas trop tard… L’histoire a longtemps circulé aux États-Unis sur les campus, notamment lorsqu’une étudiante s’aventurait à chercher un document dans des rayonnages isolés. Une légende urbaine qui s’inspire d’un fait bien réel : Betsy Aardsma1, une étudiante, a ainsi été assassinée en 1969 dans la bibliothèque de l’université de Pennsylvanie, et près de 50 ans après, ce meurtre n’est pas toujours pas résolu. La légende urbaine peut ainsi s’appuyer sur une réalité, même si ce n’est évidemment pas forcément le cas… car finalement, le but de la légende n’est pas la véracité, mais le message à faire passer.

Ces histoires pimentent toujours de manière opportune les réunions ennuyeuses. Ainsi, pour affronter une nouvelle année, il semblait utile d’esquisser quelques légendes urbaines de la documentation !

La création du CAPES de documentation serait la conséquence d’un pari perdu par Michel Rocard avec Lionel Jospin

Lionel Jospin aurait parié avec Michel Rocard l’intérêt de créer le CAPES de documentation. Rocard était hésitant d’un point de vue financier et pas totalement convaincu au niveau pédagogique. Jospin aurait donc parié avec Rocard de manière quelque peu insensée pour parvenir à le convaincre. L’influence de Françoise Chapron a été décisive dans cette histoire bien entendu auprès de Lionel Jospin, mais il fallait convaincre ensuite le Premier ministre. Début 1989, à cette demande, Michel Rocard répond tout d’abord que les Français sont plus prêts d’accepter que le groupe Début de soirée soit à nouveau premier du Top 50 avec son nouveau single « La vie, la nuit » que de comprendre l’intérêt d’un nouveau CAPES ! Jospin voit là l’occasion de voir son projet aboutir, et parie que « La vie, la nuit » ne sera jamais en tête du Top 50. Rocard continuant de soutenir l’inverse, Jospin met en jeu… la création du CAPES de documentation. La suite, vous la connaissez : Début de soirée se classera avec ce titre à la seconde place du Top 50, et le CAPES sera donc créé quelques mois plus tard. C’est David Hallyday avec son titre « High » qui demeure en tête. De là à en faire un hymne pour la profession habituée à connaître des hauts et des bas…

Un groupe œuvre pour la disparition du CAPES de documentation (en cachette. Enfin pas tant que ça)

Un groupe veut la mort du CAPES de doc. Surnommés les « débuts de soirée », rapport à la légende précédente, ils apparaissent toujours en costume, avec ou sans cravate, et souhaitent faire carrière au sein de la vie (la nuit ?) scolaire. On a soupçonné plusieurs inspecteurs d’en faire partie, mais sans en avoir la moindre preuve tangible. Depuis, le groupe cherche à remixer tout un tas d’idées reprises ici ou là et notamment dans les pays anglo-saxons pour tenter d’en faire quelque chose de moderne et d’innovant en France. Bien que le groupe semble digne de figurer dans bideetmusique.com, ils auraient conservé une certaine légitimité d’action au ministère.

Le Mundaneum de Paul Otlet existerait bel et bien, mais dans une autre dimension de l’espace-temps

Tout cela se serait produit grâce à une rencontre avec Albert Einstein chez le chercheur et philanthrope Patrick Geddes2 à Montpellier. Dans notre univers, la rencontre n’a jamais eu lieu, car les Einstein ont annulé leur visite ; par contre, dans l’univers de la documentation, cette rencontre se produit et permet la constitution du plus grand réseau de savoir de l’Histoire avec une nouvelle forme organisationnelle qui permet l’émergence d’un état supranational. Outre une plus grande accessibilité intellectuelle et matérielle à tous les savoirs du monde, les grands industriels paient des impôts au niveau supranational. Il est possible parfois d’apercevoir cet autre univers, en fermant les yeux après une lecture studieuse de quelques passages du Traité de Documentation.

Lire du Danielle Steel en regardant les émissions de téléréalité serait plus efficace qu’une lobotomie.

La rumeur circule dans les milieux professionnels depuis des années sans que personne n’ait pu confirmer si une véritable étude scientifique avait pu être réalisée à ce sujet. D’autres affirment qu’il n’y aurait absolument aucun besoin de cumuler l’un et l’autre pour obtenir le même résultat…

Le grimoire de Duplessis

Pascal Duplessis aurait écrit un grimoire sur la didactique de l’information qui ne pourrait être lu que par des initiés capables de maîtriser les principes du triangle didactique. Les services secrets de l’Inspection générale auraient tenté de s’en emparer à plusieurs reprises, mais ils se sont montrés incapables de saisir le système de classification de Duplessis vu qu’ils ne se servent que de Google. D’autres versions prétendent qu’ils auraient fini par partir tous guillerets après avoir bu la potion magique de Duplessis : un apéro dont lui seul a le secret.

La prof doc enfermée dans son CDI tout un week-end

Une professeure documentaliste aurait passé tout un week-end dans son CDI enfermée par mégarde, trop concentrée sur son projet de refaire sa classification. Ne pouvant sortir de son établissement, elle a préféré mener à bien son projet durant tout le week-end. Cette histoire semble néanmoins reposer sur quelques témoignages qui en attestent l’authenticité. On parle parfois de nuit plutôt que de week-end. Parfois, la légende s’accompagne du fait que lors de l’entreprise classificatoire, la professeur documentaliste aurait reçu la visite de Paul Otlet (dans la version CDU de l’histoire) ou de Melvil Dewey (dans la version CDD). Les plus dubitatifs prétendent qu’il n’y a pas que Pascal Duplessis qui sait faire des apéros…

La professeur documentaliste qui fait toujours chut ne sait en fait pas prononcer un autre mot

Elle ne s’exprime qu’en langage des signes bibliothéconomiques (une version très rare, que la plupart des sourds et malentendants ne peuvent même pas comprendre) et continue à exercer au sein de nos établissements. Elle aurait été aperçue récemment dans un collège de campagne très isolée après une mutation thérapeutique. Dans certaines légendes, elle porte le nom de sorcière du CDI du fait de ses doigts crochus et de son regard qui fige d’effroi quiconque tente de la regarder, ou pire de lui adresser la parole. Je n’en ai jamais rencontré, mais certains témoignages semblent conforter sa possible existence. Certains esprits rationnels tentent de nous expliquer qu’il s’agit en quelque sorte d’une métaphore du pire. Mais Chut ? ! tout cela ne pourrait être que des racontars.

La terrible légende du ou de la professeur documentaliste qui aurait catalogué tous les documents de sa maison avec BCDI

Il ou elle se serait finalement abonné à toutes les mises à jour de Canopé avec installation e-sidoc et tutti quanti, au point que cela commençait à lui revenir cher. Son conjoint aurait d’ailleurs demandé le divorce après une ultime tentative pour lui faire installer PMB… Cette légende fait froid dans le dos, mais on aime bien se la raconter entre collègues.

Un-e des auteurs à succès de la littérature érotique serait documentaliste

On n’en sait guère plus, mais il est évident que désormais, on cherche à savoir qui pourrait être cette libre plume qui a bien plus du succès avec ses récits qu’avec ses activités professionnelles. Nulle question apparemment de 50 nuances de Grey, mais de récits d’aventures où héros et héroïnes partagent bien plus que leur goût pour la littérature. On se doute qu’aucune de ses œuvres ne figure dans les rayons de son CDI. Pourtant, ne serait-ce pas une occasion de relancer les emprunts ?

Suzanne Briet aurait écrit un nouvel ouvrage sur la documentation qui n’aurait jamais été publié

La rumeur prétend qu’il aurait été écrit en anglais avec l’intention de l’éditer sous un pseudonyme masculin. On s’attend à le voir resurgir un jour ou l’autre au gré d’une découverte inattendue. Il y aurait notamment pas mal de passages sur la documentation secrète contre laquelle Briet s’est déjà exprimée, considérant qu’elle constituait une injure faite à la documentation. Du coup, on se demande pourquoi Briet aurait choisi de dissimuler elle aussi une œuvre ? À moins qu’elle ne soit maudite ? Dan Brown serait déjà sur le coup pour raconter l’histoire.

L’association des psychanalystes aurait révélé que les professeurs documentalistes sont d’excellents clients dans un rapport paru par erreur sur une liste de diffusion

Impossible de retrouver la trace de ce message, mais il témoignerait d’un fort développement de schizophrénie parmi la profession du fait de la nécessité de pouvoir exécuter plusieurs tâches différentes, en même temps ou à la suite, sur des périodes entrecoupées par des interruptions. Le cerveau finirait au bout d’un certain temps par générer plusieurs personnalités pour pouvoir répondre aux difficultés du quotidien.

Le CDI qui rend fou

Il existerait un CDI qui finirait inéluctablement par rendre fou tous ses pensionnaires au fil du temps. De nombreux professeurs documentalistes se seraient ainsi succédé et, inlassablement, tous auraient fini par avoir des comportements étranges, voire carrément suicidaires. Et ce sans compter les menaces qu’ils finissent par faire peser sur les élèves ou les collègues. La rumeur voudrait que le CDI soit adossé à l’ancien mur d’une vieille bâtisse contenant des champignons de type hallucinogène. Depuis l’émission de cette hypothèse, le CDI aurait été déplacé et la pièce attenante au vieux mur aurait vu son isolation refaite pour devenir un entrepôt dans lequel on évite de demeurer trop longtemps.

Les professeurs documentalistes, potentiels serial killers ?

Une étude aurait démontré que les qualités et compétences des professeurs documentalistes les rapprochaient de celles d’un serial killer. Ont été notamment mis en avant le fait de pouvoir réaliser plusieurs choses en même temps, la capacité à reprendre facilement le fil d’une ancienne problématique, la volonté de collecter les éléments de façon structurée, le désir de donner sens à tout ce qui paraît éparpillé et celle de marquer les esprits. Les rumeurs prétendent également que le groupe des « débuts de soirée » aurait inventé cette histoire auprès du ministère de l’Intérieur pour servir leurs intérêts. Cependant, la rumeur serait telle que beaucoup d’inspecteurs craignent d’aller rendre visite aux professeurs documentalistes. Le fait qu’ils soient moins inspectés que les autres collègues de discipline tendrait à conforter que cette légende est pour le moins prise au sérieux par l’administration.

Beaucoup d’autres légendes circulent, et il est difficile de toutes les conter. Il existe bien sûr celle du collègue qui a tellement fait de choses répréhensibles qu’il n’exerce plus sur le terrain et qu’il a pu ainsi monter dans la hiérarchie au ministère. Mais ce cas n’est pas propre à la documentation. De toute manière, le CDI demeure un lieu de légende urbi (toutes les histoires et les rumeurs des établissements finissent toujours par y circuler) et orbi (celles du monde entier y sont accessibles).

Tout cela pour vous dire, chers professeurs documentalistes, que vous avez tout pour être légendaires !

Les enjeux des pratiques participatives en information documentation

Éléments définitoires des pratiques collaboratives et participatives

Bien que par définition les activités documentaires soient fortement instrumentées, il n’en demeure pas moins que ces vingt dernières années, progressivement depuis le paradigme de l’Approche orientée usagers (Le Coadic, 1997), une place de plus en plus conséquente est accordée aux usagers, en tant qu’individus sachant progressivement s’organiser et diffuser entre eux un ensemble d’informations et de données au bénéfice d’un grand nombre en lien avec des communautés. Une part de cette organisation collective du travail se fait sans forme de prescription si ce n’est la seule volonté des acteurs de participer à un projet commun au nom d’un collectif d’appartenance, contournant régulièrement les règles et normes fixées par les instances de la formation. Par intelligences collectives et/ou collaboratives, nous entendons des modes d’organisation, de gouvernance et de considération des autres permettant à un individu, usager ou professionnel, d’organiser son activité dans un collectif d’acteurs, accepté par tous, où chacun contribue à la fourniture d’informations à tous. Nombre de travaux révèlent la richesse de l’intelligence des individus, intelligences multiples qui sont pourtant malmenées par les modes managériaux, économiques, et les formes d’exclusion sociale par le chômage. D’où la nécessité absolue d’une coordination « en temps réel » des intelligences. Ne pas reconnaître l’intelligence des autres, c’est finalement exercer sur eux humiliation, ressentiment, et partant une forme de violence.

Or l’intelligence collective ne s’instaure qu’avec une culture forte, des technologies cognitives performantes, des langues et des idées en circulation sociale. En soi, elle ne peut se décréter. Un des postulats documentaires serait qu’avec l’essor des techniques et des méthodes collectives de travail et de partage, nous augmenterions la granularité et la finesse des analyses et du traitement de l’information, luttant dès lors contre les phénomènes antérieurs de massification des connaissances et de l’information, comme l’énonce Pierre Lévy dès la fin des années 1990. Cependant, la question fondamentale de la construction de connaissance est de savoir qui a autorité et possibilité de fixer de nouvelles règles du jeu participatif social incitant à produire collectivement pour un bien commun, sans gaspiller compétence ou toute qualité humaine reconnue. Avec l’idée de fond que le groupe nourrit les apprentissages du sujet et qu’un individu ne peut apprendre seul.

Pionnière de la recherche et de l’enseignement des technologies éducatives, Geneviève Jacquinot alerte d’ailleurs sur la prétendue capacité d’autodidaxie des individus (Jacquinot, 1993). En matière d’apprentissages informationnels, il ne suffit pas d’avoir accès à des ressources mutualisées, ou d’avoir des compétences technologiques pour accéder aisément à l’information et en faire connaissance. S’auto-former, s’engager dans un processus informationnel intentionnel et participer à un processus partagé supposent de détenir une compétence sociale particulièrement discriminante qui englobe la capacité à se comporter de manière constructive dans un groupe, à coopérer et à communiquer, mais aussi à assumer des responsabilités. Cette capacité à participer à des collectifs s’apprend comme maintes autres compétences à caractère scolaire, professionnel, etc.

Le rapport à l’information : quelques intentions clefs

Accompagner puis former à la culture participative de l’information revient a minima à considérer quatre volets de la dimension informationnelle : tendre vers un renforcement de l’autonomie du sujet, organiser et s’intégrer à la dimension collective du travail, construire une citoyenneté informationnelle avec des valeurs humanistes clefs, et enfin analyser son agir informationnel. Pierre Lévy prend soin d’indiquer toute la difficulté à engager un collectif humain dans une aventure où chaque individu prendra plaisir « à imaginer, à explorer, à construire ensemble des milieux sensibles ». Le rapport de l’individu à une sorte de confiance dans un collectif humain, n’est pas aisé et immédiat. À l’heure où tout le monde manque de temps, paradoxalement Pierre Lévy indique que l’engagement dans un processus collectif nécessitera forcément du temps, le « temps d’impliquer les personnes, de tisser des liens, de faire apparaître les objets, les paysages communs… et d’y revenir » (Lévy, 1997).

De fait, Jérôme Dinet (2012), par exemple, avoue dans son travail réflexif que malgré un affichage voire des discours sur le collaboratif, nombre d’activités de recherche d’information présentent souvent une faible interaction collaborative entre les membres ainsi que des processus d’apprentissage pauvres entre les individus observés. En matière d’usages d’information se pose ainsi la question de l’utilité avérée d’un travail collaboratif au-delà des discours, des idéaux voire des utopies affichées. Les individus impliqués dans le travail collaboratif peuvent avoir le sentiment de consommer un temps inutilement passé à la gestion et la régulation du travail au sein du groupe d’appartenance, et d’engager un coût cognitif lourd pour des résultats de recherche, de sélection et d’appropriation de l’information relativement faibles.

De son côté, Nabil Ben Abdallah (2012) considère l’émergence de pratiques collaboratives, et mesure l’intérêt de considérer la recherche collaborative d’information ; il s’agit alors pour un groupe de personnes de considérer leurs activités pour « rechercher, récupérer, et utiliser des informations », le sens du partage et de l’organisation de l’activité. Cette recherche d’information oblige « à l’exigence d’un certain niveau d’entente et de compréhension partagée » (Hertzum, 2008). La collaboration et l’intelligence collective ne s’imposent pas, ne se décrètent pas. Elles nécessitent un accompagnement et des modalités de mise en œuvre anticipés, notamment par l’enseignant dans notre cas. Sans sentiment d’un intérêt commun (notion de « common ground »), la collaboration a peu de chance de réussir, rappelle Nabil Ben Abdallah. Ainsi, à l’heure où de nombreux dispositifs sont mis à disposition des enseignants et de leurs élèves/étudiants, certes la technique peut faciliter la vitesse, la quantité de traitement, la lisibilité et le design des ressources, mais elle ne remplacera pas la volonté individuelle et la conviction de chaque apprenant à s’inscrire dans un projet participatif et émancipateur.

Et le professeur documentaliste dans tout ça ?

Les articles publiés par des auteurs praticiens ou penseurs depuis l’essor du Web 2.0 font majoritairement la part belle à l’image d’un professionnel de la documentation qui apparaît comme un initiateur voire un promoteur actif de l’intelligence collective, dans l’organisation mais aussi plus largement dans la société. Il n’en reste pas moins que le professeur documentaliste reste encore fortement tributaire de l’organisation du temps et des espaces scolaires ainsi que du soutien des autres disciplines pour tout apprentissage en lien avec le travail participatif. Les questions socialement et scientifiquement vives, les projets (ÉMI, éducation à…), les controverses, sont autant de leviers à une culture participative ambitieuse. Comme suggéré par François Bourdoncle (2010), avec un Internet devenu tel un vaste « nuage » hétérogène dans lequel nous sommes tous immergés, plus ou moins aveuglement, le professeur documentaliste peut avoir vocation à coordonner un retour à l’organisation sociale et à la régulation des activités pédagogiques par les approches collaboratives et participatives.

L’observation de séances pédagogiques in situ ou telles que présentées en ligne par des professeurs documentalistes ne manque pas d’interroger le regard que l’on porte sur les outils collaboratifs et plus largement les injonctions à la participation et à la collaboration. En effet, il serait vain de penser que mettre les élèves en situation dite de collaboration ferait d’eux des usagers de l’information dotés de compétences sociales et informationnelles immanentes. Plus encore, l’injonction à participer à l’ère numérique n’est pas innocente : le « capitalisme informationnel » (Proulx et al., 2014) regorge de ces comportements consistant à fournir des données, captées et monétisées, comportements que les professeurs documentalistes ont précisément à cœur bien souvent de déconstruire. Dès lors, le choix des outils utilisés pour mobiliser les élèves autour de projets participatifs ou collaboratifs est loin d’être anodin, et il est fondamental que les enseignants documentalistes, porteurs d’une culture informationnelle référée à des concepts en information-communication (Couzinet, 2008), y soient tout à fait vigilants. Citons pour exemple le recours de plus en plus banalisé en contexte scolaire à des plateformes relevant des industries marchandes du web, sans que pour autant une déconstruction et une analyse critique en soient effectuées. La contradiction est alors de mise entre des idéaux d’émancipation sociale et intellectuelle, traversant les discours des enseignants documentalistes, et la participation à un marché de l’information et un modèle de société opposés (Cordier, 2018).

En conclusion, vouloir une école au service du collectif, même si l’enthousiasme social est là, nécessite forcément des coûts d’organisation et économique de structuration, où organisation, temporalité, nouveaux espaces doivent être interrogés et réajustés. L’utopie serait de penser que des modalités spontanées d’organisation collective d’une intelligence informationnelle, sans aucune forme d’organisation et de régulation sociale, pourraient voir le jour en se greffant naturellement aux pratiques d’information factuelles. Par conséquent, il ne s’agit plus pour les professionnels de communiquer de façon descendante aux usagers potentiels ou de décréter un passage au participatif, mais bien de considérer ces derniers au cœur du processus de communication vu comme un processus d’interactions horizontales. La culture informationnelle de la participation interroge profondément le pouvoir d’agir des individus, et la conscience de faire potentiellement partie d’un collectif, en se sentant capable d’agir par et sur ce collectif, et par conséquent sur le monde lui-même, par la production, le croisement, la confrontation de contenus d’information. Ainsi, revendiquer la culture de la participation revient à défendre un projet collectif militant mettant au cœur des apprentissages l’individu, avec ses forces, ses lacunes et ses représentations du paysage informationnel.

Apprendre à participer, participer pour apprendre

À la lecture de John Dewey se dessine une perspective précise : l’éducation par l’expérience. Toute expérience est éducative, toute éducation fait appel à l’expérience2. Pourquoi ?

En premier lieu, faire une expérience est apprendre quelque chose qui résout un problème présent, clôture une enquête, apporte un apaisement vis-à-vis du sentiment pénible que génèrent le doute, l’incertitude, le trouble. Comme le montre également Peirce, connaître est un effort dont le but est de supprimer ce sentiment afin d’atteindre la quiétude de la « croyance ». Loin d’être volontaire et artificiel, comme le doute cartésien poussé à la limite, le doute ordinaire provoque un sentiment d’insatisfaction que l’expérience organisée tente de surmonter3.

De même, selon Dewey, l’expérience naît d’un « trouble ». Elle prend le relais des habitudes dès lors que les conditions stabilisées qui constituent leur théâtre d’opérations viennent à être perturbées, — comme lorsque le sens interdit de la rue que tel conducteur emprunte quotidiennement est modifié. À ce moment-là, au lieu que l’habitude du conducteur favorise le continuum de sa condition et consolide son adaptation au monde qui est le sien, elle devient un obstacle tout aussi concret que celui que représente le panneau de sens interdit qui a changé de position. La difficulté produite est à la fois objective et subjective : au lieu d’être continue, intégrée, efficace et économique en énergie, l’habitude contractée dans le passé agit désormais de telle manière qu’elle sépare le conducteur de son environnement, qui lui-même se sépare de sa conduite4.

C’est dans l’espace de cette séparation que l’expérience advient. Dans le cadre de la thèse défendue ici (l’éducation appelle l’expérience et réciproquement), une première condition pédagogiquement utile fait son apparition : si l’expérience est un processus que déclenche un trouble au niveau des interactions entre l’individu et son environnement, et si nous apprenons par l’expérience, alors il est utile que les maîtres qui apportent des matériaux aux élèves le fassent de telle manière qu’ils suscitent une perturbation de leurs habitudes, du moins de certaines d’entre elles, afin de faire naître un étonnement, un questionnement, une exploration. Méthodologiques, empiriques ou formels, les matériaux proposés par l’école ne peuvent être reçus que dans la mesure où ils franchissent le seuil des habitudes mentales ou comportementales des élèves.

Toujours à ce niveau primitif, il est réciproquement souhaitable que l’école forme un environnement tel que les perplexités des élèves puissent s’y exprimer et y trouver des éléments d’expérience et d’enquête. Penser l’école, la salle de classe ou les activités scolaires de cette façon est particulièrement exigeant. Rien n’est indifférent : la distance du maître par rapport à l’élève, l’organisation matérielle de la salle de classe ou des horaires, le « programme », les modes de circulation dans l’école, tout compte.

Par définition, l’école ne peut être ouverte sur l’expérience qu’à la condition que ce qu’elle transmet soit aussi bien perturbateur que pouvant être perturbé. Les élèves dogmatiques dont les opinions sont fermement arrêtées sont tout aussi néfastes pour la liberté d’enquête et la libération de l’expérience de chacun que le sont les formes institutionnelles de l’école dite traditionnelle, — celle qui, à l’époque de l’apparition de l’éducation progressiste, ou dite « par l’expérience », était « conservatrice », — un terme qui signifiait que la fonction de l’école était de reproduire (au sens donné par Bourdieu à ce terme) les formes basiques de la société et d’ajuster les élèves aux attentes sociales, sans les transformer. Nous pourrions exprimer la fonction conservatrice de l’école en recourant au distinguo entre la valeur d’assimilation, qui consiste à faire fusionner l’individu et le tout, et celle d’intégration, qui respecte les interactions dont l’expérience relève structurellement. L’organisation spatiale de l’école, par exemple, illustre bien les questions en jeu : la division rigide de l’espace, le cloisonnement des pièces qui renforce celui des matières et des activités, l’estrade, la sonnerie à intervalle parfaitement régulier, le long couloir de service, tout supprime l’imprévisible et active la discipline à tous les sens du terme, l’ensemble évoquant une « institution totale », dans les termes de Erwin Goffman5. À la maîtrise spatiale correspond celle du comportement, des corps et des gestes, des rythmes et des contenus. La rencontre qui, d’une manière générale, comporte un élément de surprise, sans quoi elle n’advient pas, est prohibée. Apprendre dans de telles conditions (certes schématiquement décrites ici) n’est réellement possible que si l’élève jouit par ailleurs des conditions culturelles de sa participation, dont son entourage le fait bénéficier, et des valeurs d’assimilation qui sont la clé de la réussite.

Il est donc logique que les partisans d’une éducation centrée sur l’expérience aient souhaité décloisonner la salle de classe, les approches, l’école même afin de l’ouvrir sur le monde extérieur et réciproquement, afin d’ouvrir les diverses phases de la vie sociale à l’enfance, à la jeunesse et à l’éducation continue6. En outre, et contrairement à ce qui s’est passé en France en raison de l’impensé moniste et centralisateur qui a culminé avec le concept d’une école « unique », la même pour tous, le décloisonnement a ailleurs été conçu comme un procédé de pluralisation des méthodes, des activités, des programmes, des matières enseignées ou encore des auteurs de référence. L’éducation sinon « centrée sur l’élève », du moins penchée sur son individualité, ne relève pas d’une philosophie du laisser-faire biologique ou d’une croyance dans les aptitudes naturelles des enfants à l’auto développement, comme le pense Nathalie Bulle, mais dans l’adaptation des matériaux proposés aux capacités logiques, sensibles ou intellectuelles des apprenants7.

Ceci nous mène à un second niveau, qui est celui, non plus du déclencheur de l’expérience, mais de son déroulement. Selon Dewey, l’expérience advient en deux temps. Le premier, celui de la « situation troublée », consiste en ceci que le sujet de l’expérience est affecté de l’extérieur, ce qui se traduit par une vaste gamme de réactions qui vont de la réception sensorielle à la réaction brutale, de l’émotion à la souffrance, et ainsi de suite. L’empirisme classique repose sur cette phase de l’expérience qui est passive et souvent exprimée de manière sensualiste comme le phénomène correspondant au fait que nos sens sont « frappés » par un objet extérieur et qu’à cette occasion, nous formons en réaction une « image des sens ». Dans la perspective pragmatiste, le fait d’être affecté n’est cependant qu’une première phase de l’expérience. En l’état, elle n’est pas complète. Elle le devient quand l’individu affecté parvient à relier à certains éléments de la situation qui le perturbe un « plan d’action » destiné à surmonter le trouble qui l’affecte. Qui plus est, afin que l’expérience en cause soit accomplie, il est requis que le plan d’action prévu réussisse objectivement. Quand c’est le cas, l’individu restaure la continuité de son existence et peut reprendre le cours de ses activités. En revanche, si le trouble du départ est exacerbé, ou persiste, l’expérience reste tronquée et l’individu, en perte de pouvoir d’agir8.

Ce qui émane ici est l’importance de ce pouvoir. Le pragmatisme est une philosophie de l’action. Plus exactement, c’est une philosophie qui aborde toutes choses, la morale, la connaissance, l’éthique, la politique, l’art, dans les termes d’un agir directeur qui, sans être séparé de la pensée, en constitue la mise à l’épreuve et le correctif quand besoin est. Loin de tout dualisme, l’action est également au centre de la formation de l’individualité humaine. Knowing is doing, mais réciproquement, doing is knowing. Connaître c’est faire, mais le faire n’est qu’une agitation s’il n’est pas guidé par une idée directrice quelconque qui peut prendre la forme d’un projet ordinaire ou celle d’une théorie scientifique, sans que la logique en jeu soit différente.

Au sens le plus complet du terme, la « participation » a lieu dans et par l’expérience. Cette dernière ne peut être vécue par procuration. Elle engage l’individu et la connexion qu’il établit entre sa pensée et son action. Grâce à cette connexion, il « transforme le monde » et, se faisant, réalise certaines de ses virtualités dont l’ensemble façonne progressivement sa personnalité. Comme on l’a évoqué, la transformation est requise par l’expérience, et ce par définition : celle-ci s’accomplit dans le sein d’une évolution qui est celle de la situation initiale. Pour sonder le sol à la recherche d’une cavité, l’explorateur utilise des outils, remue la terre, réalise des tests chimiques, etc. Le chercheur à la paillasse ou l’enfant qui construit un château de sable ne procèdent pas autrement qu’en effectuant un va-et-vient continuel entre des plans d’action, la réalisation du plan et l’observation des résultats provoqués par leur manipulation. Or, d’un point de vue psychologique, cette relation interactionnelle et expérimentale au monde est une source essentielle d’individuation. En l’absence de la liberté qui consiste à faire jouer des possibilités, à jouer des rôles et à les tester, à explorer et à transformer, l’individu est « perdu ».

À la différence de l’instruction, l’Éducation sollicite les capacités physiques et psychiques des élèves de telle manière qu’il leur est loisible de perfectionner celles qui ont leurs préférences. Avec l’instruction, l’adresse est moniste, le contenu transmis figé, les facultés mobilisées bien déterminées dans un cadre prétendument « général » qu’on appelle esprit logique, mémoire, raisonnement, lesquels sont prétendument requis, à l’exclusion des autres, pour accéder aux « enseignements de base ». Avec l’éducation, l’accès au connaître est au contraire pluraliste. Face un problème dont les élèves sont alors partie prenante, chacun travaille à la bonne méthode en fonction de ses inclinations, de ses connaissances, de ses valeurs, etc. Le dessin ou la danse par exemple peuvent être mobilisés au profit de l’élaboration d’un savoir partageable. Au lieu d’être inculqué, le connu est en partie découvert par l’élève au fur et à mesure qu’il s’y applique. Il en va de même du « jardin pédagogique », par exemple celui que Maria Montessori avait intégré dans son école, le considérant comme l’outil pédagogique par excellence, susceptible de soutenir une vaste gamme de fonctions d’apprentissage, allant de l’accélération des perceptions de l’enfant aux mathématiques, la géographie, la botanique, l’histoire, le tout sur fond de sociabilité et d’auto- organisation. Finalement, avec le dressage ou le conditionnement s’élabore par contre un processus qui requiert, non plus l’usage de certaines facultés au détriment d’autres jugées anti scolaires, – notamment les facultés créatrices –, comme dans le cas de l’instruction dite « publique », mais la mise en sommeil des facultés individuelles au profit d’une pure et simple réceptivité dont le degré de conscience est indifférent. Si l’on en croit par exemple les fondateurs du behaviorisme, le conditionnement est d’ailleurs d’autant plus parfait que la conscience n’est pas mobilisée. C’est sous la surface des représentations et des vouloirs qu’il opère, en mobilisant les « instincts » et les processus psychiques primaires qui ne disparaissent ni n’évoluent en aucun de nous. Tel le chien que Pavlov était parvenu à faire saliver au son de la cloche qu’il agitait au moment de la présentation de nourriture, puis sans elle, l’individu réagit au contexte social d’une manière déterminée d’avance. D’après le fondateur du behavioriste John Watson, l’individu n’agit pas, il est agi par la société dont la fonction rationnelle est de produire des stimuli déterminés pour obtenir des réponses déterminées et des comportements souhaitables et prévisibles.

Qu’ils s’adossent à une technique de terreur ou pas, le dressage et, dans une certaine mesure, l’instruction, ne font pas appel à la participation des élèves, ni même, dans bien des cas, à celle des professeurs, chargés d’obtempérer face à des injonctions émises par leur « hiérarchie » et, au mieux, de trouver les moyens pour atteindre au mieux et au plus vite les finalités prescrites de l’extérieur.

Bien que les méthodes d’exclusion de la participation soient nombreuses, elles peuvent être rangées dans deux catégories. Dans la première se trouvent celles qui dépendent de pratiques coercitives qui s’exercent contre les phases d’engagement émotionnel et intellectuel des membres de la communauté scolaire, et les destituent de responsabilités aussi bien individuelles que collectives. À l’engagement se substitue la docilité et l’obéissance, ce dont l’idée même de « discipline » est la juste illustration. Dans la seconde catégorie se trouvent à l’inverse un ensemble d’anti-méthodes qui prennent le contre-pied des premières, en préconisant la suppression de toute ingérence dans le développement de l’enfant au profit de l’expression prétendument ordonnée et automatique de ses facultés « naturelles ». L’école anarchiste libertaire par exemple, dans une certaine mesure la pédagogie Waldorf-Steiner, et l’ensemble des pédagogies acquises à l’idée d’un « laisser-faire » de l’enfant et d’une intervention minimum, – qui ne sont pas sans rappeler la doctrine du libéralisme économique –, non seulement reposent sur une conception métaphysique d’un « l’individu tout fait » dont l’expérience montre le caractère purement fictif mais, en outre, privent les jeunes des éléments qui leur apporteraient les matériaux nécessaires à leur entrée dans l’expérience et, par suite, à leur pleine participation sociale et individuelle et donc, à la croissance de leur personnalité distinctive.

La participation requiert qu’un juste milieu soit trouvé entre la dépendance de l’individu à l’égard du milieu et la vacuité d’un milieu sans relief faute d’être structuré par la communauté ou plus exactement, par les expériences accumulées des générations successives. Que l’école effective doive réaliser un tel équilibre, qu’elle subordonne ses méthodes, son curriculum, ses finalités culturelles et sociales, à la recherche de cet équilibre, voilà ce qui constitue l’apport fondamental de la philosophie de l’éducation de John Dewey.

Pratiques participatives, l’école démocratique au collège ?

Un CDI de collège, c’est un peu l’école démocratique pour tous

Les écoles démocratiques, qui proposent le modèle d’une pédagogie alternative libre, sans cours ou programme préconçus, sont très médiatiques et attirent les familles. Elles y voient la possibilité pour leur enfant d’être « respecté » dans son identité et son rythme « naturel » d’apprentissage. Avouons que chacun d’entre nous a un jour regardé d’un œil envieux ces atmosphères paisibles de travail, où chaque enfant vaque à ses occupations. Une sorte de famille nombreuse joyeuse et active, sans les conflits de fratrie ! Un œil de professeur documentaliste ne pourra s’empêcher de déceler dans les reportages consacrés à ces écoles des ressemblances avec le fonctionnement de certains CDI : les élèves choisissent leurs activités librement ; ils sont actifs dans ces activités ; ils collaborent entre eux, et avec des adultes avec lesquels ils ne sont pas systématiquement en situation de hiérarchie ; ils ont droit d’émettre des idées, de proposer et d’animer des activités…

Peut-on pour autant dire des CDI qu’ils sont des graines d’écoles démocratiques au sein de l’école classique ? À lire le mot d’ordre de la Communauté Européenne pour l’Éducation Démocratique (EUDEC), on pourrait le croire : « Les jeunes devraient pouvoir choisir ce qu’ils font, quand, où, comment et avec qui, du moment que leurs décisions ne transgressent pas la liberté des autres de faire de même. Ils devraient aussi jouir d’une part égale du pouvoir de décision sur le fonctionnement de leur organisation, notamment sur le règlement intérieur et son application, participant ainsi à y instaurer un cadre de liberté, confiance, sécurité et respect.1 »

La question se pose avec d’autant plus de pertinence que, ces derniers temps, les CDI sont sollicités pour proposer des coins/espaces/ateliers participatifs et collaboratifs, le plus souvent sur un mode facultatif. L’accent est mis sur ces modes de fonctionnement (remixons les CDI, design thinking, espaces autonomes). Et l’on peut se demander si c’est une évolution incontournable parce qu’à la mode, ou nécessaire parce que positive.

Un CDI assurément collaboratif…

J’aime l’idée que les élèves soient autonomes, libres et responsables. Et cela tombe bien, ils apprécient aussi. Au fil des années, j’ai donc progressivement mis en place dans mon CDI d’exercice un fonctionnement collaboratif et autonome, proposé à tous les usagers. Ceux-ci peuvent cependant faire le choix de l’ignorer en restant des usagers passifs, en demandant de l’aide ou en ne saisissant pas les opportunités facultatives proposées. Mais cela convient au plus grand nombre, et à une grande variété d’élèves : ceux qui aiment qu’on leur fiche la paix, ceux qui ont besoin de valorisation en rendant des services, ceux qui ont le goût de se débrouiller seuls. En cas de besoin, ils demandent assez spontanément à un élève plutôt qu’à moi. J’encourage ce type de collaboration, en demandant à un élève de 6e de montrer à un 3e le fonctionnement de tel espace, ou en créant des binômes de jeux entre deux élèves qui ne se connaissent pas. Je vois les effets positifs de ce fonctionnement dans le décalage d’attitude entre les élèves initiés depuis la 6e lors des séances nombreuses d’explication, et ceux qui arrivent en 4e. Il y a chez ces derniers une sous-utilisation du lieu, et une utilisation passive. Ils sont parfois revendicateurs, et agissent comme des consommateurs en droit d’exiger ceci ou cela. Cela dénote avec l’attitude des autres élèves, qui vont davantage demander ou suggérer.

Symboliquement, j’ai depuis toujours préféré le bureau central au bureau de surveillance à l’entrée. Il est devenu officiellement « bureau collaboratif » l’an dernier. Il concentre, pour les mettre en valeur, les activités à partager (numériques, ludiques, d’aide et d’entraide). Des chaises tout autour invitent les élèves à s’installer à mes côtés.

J’ai choisi une posture d’accompagnant et d’organiseur. L’espace leur appartient, j’en suis juste la gardienne et la superviseuse. Le prêt est ainsi totalement autonome, avec une table rassemblant tout le matériel nécessaire. Une boîte à lettres à la vie scolaire permet de rendre les livres à un autre endroit que le CDI, et ce sont des élèves volontaires qui la vident aux récréations. La plate-forme de recherche Esidoc est utilisée comme un outil d’autonomisation et de collaboration : pour la remédiation ou l’approfondissement, avec des jeux de révision, des vidéos ; pour les activités collaboratives ou autonomes, avec des sites et des informations ; pour proposer des achats ; pour réserver des livres ; pour consulter le planning du CDI, et communiquer avec le professeur documentaliste via l’adresse email communiquée. Des espaces autonomes sont proposés sur les heures d’étude : guitare en libre accès pour les joueurs auditionnés ; espace autonome de méditation/relaxation (avec possibilité de réserver) ; espace « jeux de stratégie » accessible en fin d’heure d’étude.

Les élèves sont associés à la réflexion sur les espaces et le fonctionnement du CDI. Une enquête annuelle permet de recueillir les avis, positifs et négatifs. Ayant lu beaucoup d’articles sur des expériences de design thinking, j’ai organisé l’an dernier une réunion avec des élèves volontaires, intitulée « chantier de réflexion collective ». Avec une dizaine d’élèves, nous avons utilisé les fameux post-it pour lister ce qui allait, ce qui n’allait pas, et nos idées. Les semaines suivantes, à chaque heure d’étude, les élèves étaient sollicités pour donner leur avis, ce qui a permis de mobiliser davantage d’usagers. Nous avons testé certaines propositions pendant plusieurs semaines, et un suivi a été réalisé.

À côté de ces usages proposés à tous, pour des besoins scolaires ou personnels, il y a des activités proposées sur la base du volontariat, sur les temps du midi (les clubs) ou sur les heures d’étude (ce qui permet aux externes de s’impliquer). Au premier rang de ces activités périscolaires, donc facultatives, on trouve les aides CDI (« Z ») : ils aident à ranger (maîtrise des classements), à faire des sélections de livres (esidoc) et rendent des petits services. Les coachs numériques, eux, sont initiés au maniement du matériel et des logiciels (liseuses, tablettes, scanner, padlet, publication sur le site du collège…). L’organisation du groupe reproduit un fonctionnement assez « naturel ». Le cadre est moins carré que les expériences d’experts numériques qu’on peut voir. C’est un peu « comme à la maison », on décide ensemble, on réfléchit ensemble, on adapte les règles ensemble.

Deux clubs proposés le midi complètent la palette des activités, l’un réservé à la lecture, et l’autre aux jeux (de stratégie, de lettres). Dans le cadre de ces clubs, les habitués acceptent facilement de prendre le rôle d’encadrant pour me seconder, et il est très facile de trouver des volontaires pour aider à ranger les armoires. Il arrive que des élèves demandent à pouvoir proposer d’autres activités de type club, qu’ils gèrent alors de A à Z. La pièce du CDI qui accueille les clubs leur est dans ce cas réservée.

Pour que tous ces dispositifs soient compris et investis par les élèves, cela nécessite une signalétique claire et explicite, ainsi que des séances approfondies de découverte des espaces, des règles et des activités proposées. Il faut donner les clés aux nouveaux élèves : les 6e, mais aussi les 4e qui arrivent, ou tout nouvel élève. La visite est également faite à tout nouveau personnel de la vie scolaire, pour qu’il appréhende le fonctionnement du CDI, et la manière dont il s’articule avec l’offre elle aussi variée proposée par la vie scolaire. Dans le cadre des séances dirigées au CDI, certaines habitudes systématiques permettent de faire vivre un mode de travail autonome et collaboratif y compris dans le cadre des enseignements obligatoires – dans la limite du raisonnable selon le travail demandé par l’enseignant - : tirage au sort avec galets et dés à jouer, organisation avec un élève pilote à l’ordinateur, utilisation de quatre couleurs pour les activités de réflexion individuelles et en groupe2, guides de recherche semi-guidés.

… avec des bénéfices évidents,

Ces activités apportent un plus :

• pour les élèves participants : responsabilisation, engagement, implication, plaisir ;

• pour tous les usagers, même simples visiteurs : autonomie et liberté ;

• pour l’adulte : sentiment d’être moins isolé dans la prise de décision concernant le lieu, et satisfaction d’œuvrer pour l’épanouissement des élèves ;

• pour la relation avec les élèves : du respect mais moins de distance qu’avec un enseignant de discipline. On est davantage un référent et un gestionnaire qu’un supérieur hiérarchique qui imposerait son système.

Je me suis tout à fait retrouvée dans un témoignage sur l’excellent site Remixonsdoc des collègues de Toulouse : « Les « événements du midi » favorisent les relations interpersonnelles et les émotions, montrent les bienfaits du partage, favorisent le développement de l’estime de soi. Ils donnent aussi une place aux goûts et aux passions individuelles. »3

Mais pas tout à fait comme à l’école démocratique !

Si je valorise chez les élèves un fonctionnement responsable, autonome et participatif, je ne respecte finalement pas les principes de l’école démocratique à la lettre. J’ai effectivement « faussé » le fonctionnement d’un CDI naturel, de différentes manières.

Tout d’abord, les règles de vie ne sont pas décidées en collaboration, même si les élèves peuvent proposer des modifications. Lors des enquêtes menées auprès des élèves chaque année, leurs demandes sont de pouvoir parler à plus de deux, faire leur travail scolaire, dessiner, dormir, téléphoner. C’est de bonne guerre de leur part de tenter le coup, mais j’estime ne pas avoir à réunir de réunions d’élèves pour arbitrer ces propositions. Pour autant, il n’est pas question de faire preuve d’abus de pouvoir, les règles sont réduites au maximum et mettent à égalité les adultes et les élèves. Les règles de vie s’affichent cette année en couleur et officialisent l’entraide et le partage.

Afin de préserver le calme tout en permettant beaucoup d’activités différentes, beaucoup d’autonomie et des déplacements forcément nombreux, les règles d’organisation sont assez strictes et leur application sans concession ni exception : obligation de s’occuper (ou de demander à l’être), interdiction d’être plus de deux élèves sur une activité (sauf sur la table collective), interdiction de déplacer une chaise, interdiction d’aller aux ordinateurs sans autorisation.

Je n’ai pas non plus conservé l’idée d’une co-gestion à égalité des activités. L’expérience a montré que la cooptation entre élèves est fort utile du point de vue de la socialisation, mais nettement moins de celui de l’efficacité… Je conserve donc ce système pour certaines activités (découverte de l’espace jeu, guitare, liseuse…) mais pas pour celles qui demandent à être effectuées précisément (rangement, saisie des carnets). Il peut y avoir initiation par un élève, mais au bout du compte, c’est l’adulte qui vérifie et valide la compétence, donnant ainsi à l’élève formé le droit et la qualification pour montrer à d’autres.

Enfin, et c’est peut-être le point qui soulève le plus de questions, j’ai faussé un fonctionnement naturel en proposant des activités. C’est contraire aux principes de l’école démocratique, où l’idée est de ne rien imposer. Si l’on voulait essayer de reproduire les conditions préconisées par les écoles démocratiques, il faudrait ne rien proposer sur les heures d’étude, ne rien proposer comme club, ouvrir simplement la pièce et attendre que les élèves demandent une activité. J’ai vécu quelques situations qui peuvent nous mettre sur la piste de cette uchronie. Le club relaxation existe depuis 10 ans, et il manque de place pour accueillir les élèves tant la demande est forte. On a imaginé, avec la collègue responsable du club, un espace autonome de relaxation/méditation au CDI depuis cette année. Il ne désemplit pas. Pourtant, aucun élève n’avait eu l’idée d’en faire la demande. L’an dernier, un collègue de sciences physiques a proposé des énigmes scientifiques au CDI. À notre grand étonnement, cela a eu un succès fou ! Beaucoup d’élèves avaient pris l’habitude de cogiter, demander des indices, proposer des solutions, et venaient assister nombreux aux démonstrations de la réponse. Lorsque le collègue a muté en lycée, personne n’a fait de remarque, ou appelé de ses vœux la poursuite de cette activité…

De même, la lecture loisir, on le sait, a du mal à évoluer sans sollicitations. Je parle souvent du pouvoir de la gestion de l’espace, en disant que « la pédagogie passe aussi par la place des chaises » : mettez un siège devant un bac de magazines, d’albums, et ils seront lus ; enlevez le siège, vous pouvez arrêter les achats. La plupart des élèves lisent ce qui est à bout de bras et n’iront pas chercher un titre pour aller s’installer ailleurs. Loin des yeux…

Mais même en étant force de proposition, toutes les activités sont-elles possibles dès lors qu’elles se basent sur le volontariat ? Lesquelles « prennent » et lesquelles n’ont pas de public ? À quels élèves profite réellement ce système participatif et collaboratif ?

Les limites du volontariat

Quand je propose les Z, les coachs numériques, les siestes contées, l’espace relaxation en autonomie, les clubs, je me fais plaisir, et les élèves sont ravis. Mais qui sont ces élèves ravis ? Sont-ils nombreux ? Les raisons de leur ravissement rejoignent-elles mes objectifs pédagogiques (lecture, info-doc, EMI, ouverture culturelle, avec TOUS les élèves) ? Brisons tout de suite le suspens : très peu participent, de moins en moins au fil des années, et leur ravissement n’est pas toujours en adéquation avec le mien.

Prenons l’exemple du club lecture. Pendant longtemps, quatre clubs lecture vivaient au CDI. Puis les élèves se sont faits de plus en plus rares, et j’ai dû inventer une formule libre où les élèves viennent faire l’activité qu’ils souhaitent, du moment que cela a un rapport avec un livre (exposé, vidéo, rangement…). Ce sont rarement les mêmes, et peu de projets aboutissent. Je me rassure sur mon éventuelle responsabilité dans ce tarissement en voyant mes collègues se désoler de ne plus avoir d’élèves au club math, au club magie, au jardinage, à la chorale…

Ne perdons pas de vue que ces activités facultatives s’adressent aux élèves qui viennent au CDI, d’une part, et, parmi ces usagers (qui ne sont donc pas la totalité des élèves d’un établissement), aux volontaires. Il faut être très clair sur la nature et les conditions de ce volontariat, et ne pas se voiler la face. Le volontariat, ce n’est pas très démocratique. Tout d’abord, ces activités s’adressent aux élèves qui sont tentés. On pourrait parler de « volontariat culturel », de curiosité. Il n’est pas donné à tout le monde de se dire : « Tiens, si j’allais découvrir des choses nouvelles ? ». C’est une initiative très dépendante des habitudes culturelles familiales. Ensuite, il faut que les élèves soient disponibles matériellement. On peut donc oublier les externes, habitués à libérer le terrain par manque de surveillants et de salles d’étude. Exit aussi les élèves qui préfèrent faire leur travail au collège pour s’avancer, ce qui n’est pas vraiment critiquable. Exit enfin les élèves suivis dans des dispositifs type « devoirs faits » ou soutien. On peut aussi éliminer de nos listes les élèves hyper-occupés, qui ont AS le lundi, chorale le mardi, soutien en math le jeudi, et préfèrent jouer au ping-pong que venir au club lecture sur le seul midi qui leur reste. Mais d’un point de vue démocratique, ces élèves-là n’ont pas besoin de nous, on est juste parfois un peu frustrés de ne pas les voir assez pour nous aider à dynamiser notre fonctionnement.

Il faut aussi oublier les élèves « indépendants », ceux qui veulent TOUT faire seuls sans contrainte, et parfois en dehors de l’école. Les lecteurs me l’ont dit très clairement dans la dernière enquête : ils ne veulent pas du cadre contraignant d’un club ou d’une animation lecture. Exit donc le club lecture à la rentrée, ou profit d’un CDI juste ouvert le midi.

Par ailleurs, la collaboration volontaire a ses limites. En effet, il n’est pas certain que ce soit une bonne chose au niveau pédagogique de prévoir par exemple que des élèves « experts » aident systématiquement les élèves à notre place : ils n’ont inévitablement pas le même niveau de compétence que le nôtre. Souvent, en essayant d’aider, ils se rendent compte qu’ils ne savent pas bien faire eux-mêmes. De plus, ils ne sauront pas aider, ils feront à la place, parce qu’aider, cela s’apprend. Un « aide-doc » va chercher à la place d’un autre élève, il n’aura pas la même démarche que le professeur documentaliste qui va repérer les erreurs, les souligner et les corriger, ou qu’un élève qui va tâtonner pour y arriver par lui-même. Si au hasard de leur vie scolaire, leurs compétences leur permettent d’aider un camarade, ils sauront s’en servir, mais cela ne doit pas être l’objectif.

Enfin, il faut aussi se demander si l’on n’est pas en train de se servir des élèves, au lieu de leur rendre service. Les Z n’ont pas à assurer le rangement du CDI, et les coachs n’ont pas à remplacer une formation informatique ou numérique de tous les élèves. Cette réflexion m’a amenée à faire évoluer ces deux projets à la rentrée prochaine, pour prendre la forme de missions plus utiles aux élèves. Il me semble plus pertinent de créer une équipe d’animateur du CDI que des « rangeurs » d’étagères, et de former des journalistes (papier, télé, radio ?) plutôt que des techniciens informatiques. Je préfère faire mon métier de professeur documentaliste, plutôt que d’essayer de pallier les manques de formation informatique et numérique.

Intégrer des éléments participatifs, collaboratifs dans les cours obligatoires ?

Nos objectifs d’apprentissages concernent l’EMI, l’info-doc, l’ouverture à la culture et l’incitation à la lecture. Et nous devons toucher tous les élèves, qu’ils soient volontaires ou réfractaires, qu’ils soient initiés familialement ou pas, qu’ils aient des heures d’étude ou pas.

Ne faut-il pas dès lors imaginer introduire du participatif, de la collaboration, dans les projets pédagogiques obligatoires, ceux qui s’adressent à tous dans le cadre de l’enseignement ? On peut le faire dans l’organisation du travail des élèves (travail en équipe, liberté d’organisation, référent désigné…), dans les outils utilisés (outils numériques collaboratifs), dans la restitution du travail (liberté de choix du support, co-évaluation, présence discrète des adultes…). Tous ces moyens font l’objet de publications nombreuses. Leur point commun, c’est d’être très intéressants du point de vue de la pédagogie, mais malheureusement moins du côté de la gestion du temps. Or, la problématique du manque de temps n’est pas à négliger. Elle aboutit souvent à faire manquer l’un des objectifs : celui de l’apprentissage de la méthode, ou celui du contenu d’enseignement. La collaboration est un objet d’apprentissage en soi. La solliciter aboutit souvent à une surcharge cognitive pour les élèves, qui puiseront des bénéfices comportementaux et sociaux à ce mode de travail, peut-être au détriment des savoirs acquis. Il faut donc en avoir conscience pour adapter les objectifs et la difficulté de la tâche finale demandée. André Tricot, dans ses nombreux travaux, parle des quatre niveaux d’engagement dans la tâche, de charge et surcharge cognitive.

Depuis la réforme du collège, les heures-CDI ont été diminuées des deux-tiers dans mon collège. J’ai donc considérablement adapté ma manière de travailler avec les classes. On l’a vu, une activité qui laisse la part belle au collaboratif prend aussi beaucoup de temps, et le contenu des savoirs mobilisés ne doit pas rajouter une difficulté aux élèves. J’avais pris l’habitude de prendre comme sujets d’exposés des contenus simples : le CDI, des événements vécus par les élèves, un livre lu, un auteur connu… L’idée était de privilégier l’apprentissage des outils de recherche, des outils de mise en forme, de l’autonomie et du travail en équipe. Aucun collègue de discipline ne pourrait y trouver son compte en l’état, le projet est stérile ou presque en termes d’acquisitions de nouvelles connaissances. Si on demande aux élèves de découvrir un sujet nouveau, qu’ils doivent maîtriser et comprendre, il faut que la méthode demandée ne soit pas nouvelle ni difficile.

Il s’agit donc aujourd’hui de trouver d’autres manières de travailler avec les collègues, pour que les projets auparavant initiés par le professeur documentaliste seul puissent se retrouver dans le cadre des enseignements de discipline. C’est une réflexion à mener en équipe, en ayant conscience qu’être collaboratif peut s’apprendre par l’expérience, bien sûr, à la condition de vivre beaucoup d’expériences répétées, souvent ratées et non abouties, ou alors que cela peut s’enseigner de manière progressive et concertée. Ainsi, on ne peut pas mettre sans préparation une classe en autonomie, en exigeant une organisation en équipe, une démarche laissée à leur appréciation, l’usage d’un brouillon collaboratif en ligne type framapad, une mise en forme de leurs recherches avec un autre outil collaboratif numérique ou l’organisation d’un oral. Cela semble évident, et pourtant, le seul fait de leur demander de réaliser ce travail très souvent sur leurs heures de liberté est significatif d’une méconnaissance des difficultés induites par toutes les étapes de ces missions éminemment complexes, mais potentiellement fécondes pour les élèves.

On lit que les temps ont changé, que les élèves ont besoin de travailler d’une autre manière, plus libre, plus collaborative. Je ne peux qu’adhérer à ce souhait, ayant dans ma pratique pu observer les multiples intérêts de ces modes de fonctionnement. Mais il faut à mon avis éviter que le corollaire n’en soit le volontariat.

Certains collègues éprouvent aujourd’hui des difficultés à continuer leurs missions obligatoires à destination de tous les élèves. Restons vigilants pour que le fonctionnement d’un CDI « moderne » et « démocratique » (il paraît qu’il faut dire innovant) respecte l’équilibre de ses missions, et que le « facultatif » ne vienne pas au détriment de la formation de tous les élèves.

L’élève médiateur, un levier pour la participation et la motivation

Faire participer les lycéens, les amener à être des citoyens actifs au sein de l’établissement et de ses institutions est un défi dans le lycée où j’enseigne. Quand je suis arrivée, il y a presque dix ans, la MDL avait été fermée, faute d’avoir trouvé un fonctionnement, malgré les efforts conjoints de la vie scolaire et de la direction. Depuis, elle a été réouverte après avoir entièrement été réaménagée, mais les élèves continuent à avoir du mal à se sentir responsables du lieu et la cotisation très modeste demandée en début d’année pour en bénéficier est vécue comme un obstacle insurmontable par de nombreux élèves. Rendre l’élève acteur de ses apprentissages est dans ce contexte bien difficile, car leur adhésion aux projets culturels est souvent liée uniquement à l’espoir, ou à la menace, d’une note. Le projet d’établissement, comme le projet documentaire en cours, place la participation de l’élève au cœur du projet pédagogique. Dans ce contexte, nous avons multiplié les actions visant à responsabiliser l’élève et à l’autonomiser en le plaçant dans la position de médiateur avec des résultats évidemment divers. Nous avons repéré plusieurs dispositifs favorisant cette position de médiateurs chez les élèves comme la participation annuelle au salon du livre policier de la ville, à la semaine culturelle organisée au sein du lycée, à des projets européens, ou des usages particuliers du lieu, délégués CDI et mise en place progressive d’un espace de fabrication numérique basée sur un club de programmation. Les modalités de médiation varient selon les projets, les élèves devenant médiateurs pour leurs pairs, pour des élèves extérieurs à l’établissement ou pour le grand public, en fonction des contextes. Cette position proposée aux élèves est évidemment plus ou moins investie, mais les résultats demeurent encourageants en termes d’implication des élèves, de participation à la vie du CDI et devient même dans certain cas un outil pour le raccrochage scolaire.

Délégués CDI

Au cours de ces dix dernières années, nous avons mené de nombreuses expérimentations avec des résultats plus ou moins probants. Parmi les différents projets menés, c’est finalement le plus simple qui a eu le plus de répercussions en termes d’implication des élèves, bien au-delà de nos attentes. En effet, bien que nous soyons deux professeurs-documentalistes, les horaires étendus du lycée et notre implication pédagogique font que nous ne pouvons pas toujours ouvrir le CDI aux élèves soit de manière régulière (aux récréations, à la pause méridienne) soit de façon exceptionnelle quand nos projets nous amènent à travailler en co-animation en classe notamment. L’importance d’horaires d’ouverture réguliers et bien observés est indubitable pour une bonne fréquentation des lieux mais nous ne voulions pas nous priver de travailler hors les murs du CDI, ce qui a aussi des effets pédagogiques pertinents.

Nous avons donc proposé à la direction une variante des dispositifs de délégués CDI courants dans les collèges permettant d’ouvrir le CDI en dehors de la présence des professeurs documentalistes. Il y a eu quelques trépidations mais un test a été accepté avec des Terminales. Il s’agissait de proposer à des élèves, fréquentant régulièrement le CDI et respectueux de son fonctionnement, de se former pendant une heure avec nous, de signer une charte et en échange de pouvoir se faire ouvrir le CDI en notre absence avec au maximum trois autres élèves de leur choix. Cette organisation est rendue possible par la proximité immédiate de la loge et par l’équipement des deux portes du CDI en barre anti-panique. Une fois que les élèves se sont enregistrés dans un cahier à la loge, la porte leur est ouverte sur présentation de la carte de délégué de l’un d’entre eux, puis refermée derrière eux. De cette manière, le délégué n’est responsable que des trois élèves qu’il a choisis. La formation consiste en un rappel des règles de fonctionnement du CDI, de l’explication du fonctionnement de CDIstat et de l’emprunt et du retour de documents via BCDI. Un compte spécifique a été créé ne permettant que ces opérations. A la fin de l’heure, le délégué signe une charte où il s’engage à respecter le fonctionnement normal du CDI et il est pris en photo pour l’élaboration de la carte. Au départ, conçue comme un moyen pour la loge d’identifier les élèves délégués du CDI, cette carte s’est avérée essentielle dans l’implication des délégués qui y voient une reconnaissance. Certains anciens élèves, maintenant dans le supérieur, ont fièrement conservé cette carte de délégué CDI…

Mis en place pour répondre à un besoin pratique d’ouverture du CDI, ce dispositif a eu des répercussions inattendues. Dès le départ, il a très bien fonctionné avec un grand respect des élèves sélectionnés, ce qui a rassuré et la direction et le personnel de la loge. Le dispositif, limité originellement à une dizaine d’élèves de Terminale, a ainsi pu rapidement être étendu et a incorporé des Première.

Il compte maintenant une trentaine d’élèves chaque année qui comprend des élèves identifiés par nos soins en fin de Seconde et des demandes au cours de l’année d’élèves souhaitant entrer dans le dispositif. Dans la mesure du possible, dans cet établissement de huit cents élèves, nous essayons d’avoir deux délégués par classe de Première et Terminale, de préférence ne faisant pas partie du même cercle amical. Les élèves délégués une année demandent systématiquement leur prolongation les années suivantes, que ce soit en Terminale ou jusqu’en BTS, montrant l’appropriation du système. Le premier effet constaté, outre de faciliter l’accès au CDI, a été une augmentation importante de la fréquentation des élèves de Terminale, jusque là peu présents en accueil libre. Un deuxième effet a été un investissement de certains délégués dans la vie du CDI. Plusieurs groupes d’élèves nous ont proposé spontanément de réaliser des expositions et des actions : exposition sur les attentats du Bataclan, collecte de fournitures scolaires pour Haïti, aide au rangement des livres, au montage d’expositions…

D’autres ont pris à cœur leur rôle de délégué en jouant les médiateurs, aussi bien pour faire respecter les règles de vie du CDI par leurs pairs alors que nous sommes présents qu’en intervenant auprès d’élèves lorsque des difficultés surviennent, notamment autour de l’usage du téléphone portable. Enfin, la plupart des délégués prend rapidement l’habitude de proposer à des élèves en-dehors de leur cercle de venir avec eux lorsqu’il leur reste des places, parfois à notre demande pour des secondes fréquentant régulièrement le CDI et souhaitant rester alors que nous fermons, parfois de leur propre initiative lorsqu’ils sont à l’aise dans leur rôle de médiateur. Cela a ainsi créé des réseaux informels interclasses et/ou inter-niveaux lorsque des intérêts communs apparaissaient lors de ces séances, comme le dessin manga ou le jeu vidéo. Nous encourageons évidemment ces initiatives qui mettent en valeur les élèves médiateurs, notamment en leur proposant des ouvrages, des activités et en les amenant à co-animer des ateliers sur leurs intérêts lors de la semaine culturelle de l’établissement.

Cette reconnaissance par les pairs comme par les professeurs-documentalistes d’un statut particulier de médiateur est un élément important pour certains de ces élèves et contribue à leur assiduité dans l’établissement tout au long de l’année. En effet, un dernier effet induit par ce dispositif que nous avons pu constater est d’aider des élèves en raccrochage scolaire. Nous accueillons, sur demande de la vie scolaire et selon un emploi du temps fixé en commun, certains élèves en difficulté avec le système solaire en leur offrant la possibilité de venir au CDI, le temps de reprendre l’habitude de venir régulièrement au lycée. Le CDI joue alors le rôle d’un lieu de transition pendant une durée plus ou moins longue, et nous les accompagnons le temps de réfléchir à leur orientation, de rattraper les cours et de reprendre des habitudes scolaires en travaillant sur le lire-écrire. Nous proposons systématiquement à ces élèves d’être délégué CDI à l’issu de cette période car le lieu devient pour eux un point d’ancrage nécessaire alors qu’ils reprennent les cours, et parfois un refuge lorsque les difficultés surviennent à nouveau. Leur familiarité avec le CDI leur permet d’assumer progressivement un rôle de médiateur et nous les encourageons en leur demandant au fur et à mesure, en restant attentif à leurs réactions, des petits services : assurer le rôle de délégué CDI le temps pour l’un d’entre nous de réaliser des photocopies, assurer l’accueil des élèves pendant que nous faisons cours, faire les retours d’emprunt… Lorsqu’ils ne changent pas d’établissement, ils sont volontaires l’année suivante pour être délégué CDI et leur position de médiateur semble leur permettre une meilleure intégration dans la classe et une meilleure assiduité. Il ne s’agit que d’un ou deux élèves par an dans ce cas particulier mais d’autres délégués profitent aussi de cette sociabilisation induite par la possibilité d’ouvrir le CDI à leurs pairs.

Il faut cependant nuancer ces résultats car il convient de mentionner que de rares élèves, pourtant très présents au CDI, refusent la proposition, ne souhaitant pas endosser la responsabilité de délégué CDI. D’autres élèves délégués CDI ne l’acceptent que pour eux et leurs amis proches et ne s’investissent pas plus. Dans tous les cas, le dispositif n’a pas connu en quatre ans d’existence de dysfonctionnement, et il est exceptionnel de devoir intervenir auprès de ces élèves pour rappeler l’une ou l’autre des règles de fonctionnement du CDI lorsque nous sommes présents. La proposition d’être délégué CDI semble être généralement vécue comme un privilège et une reconnaissance par les élèves au-delà de l’intérêt de bénéficier du lieu en notre absence. Le rôle de médiateur des délégués CDI, quel que soit le degré d’investissement de l’élève, renforce leur appropriation du lieu et par extension du lycée.

Os court et oscar

Positionner l’élève comme médiateur ne fonctionne pas seulement dans le cas de relation individuelle comme avec les délégués CDI mais aussi dans le cadre de groupes pédagogiques pour les impliquer dans des projets culturels. En effet, nous sommes très investis dans l’accompagnement personnalisé en Seconde, en travaillant seuls avec un groupe de chacune des sept classes. Nous participons aussi régulièrement en co-animation en AP en Première, en fonction des projets menés. Un des points forts de l’année est le salon PolarLens fin mars, lors duquel nous accueillons au lycée un auteur et pour lequel nous proposons des expositions et des interventions en fonction du thème fédérateur, depuis maintenant quatre ans. Chaque projet proposé aux élèves le positionne comme médiateur soit pour le grand public qui vient au salon, soit pour les élèves de primaire de la ville qui y participent.

Positionner l’élève comme médiateur ne fonctionne pas seulement dans le cas de relation individuelle comme avec les délégués CDI mais aussi dans le cadre de groupes pédagogiques pour les impliquer dans des projets culturels. En effet, nous sommes très investis dans l’accompagnement personnalisé en Seconde, en travaillant seuls avec un groupe de chacune des sept classes. Nous participons aussi régulièrement en co-animation en AP en Première, en fonction des projets menés. Un des points forts de l’année est le salon PolarLens fin mars, lors duquel nous accueillons au lycée un auteur et pour lequel nous proposons des expositions et des interventions en fonction du thème fédérateur, depuis maintenant quatre ans. Chaque projet proposé aux élèves le positionne comme médiateur soit pour le grand public qui vient au salon, soit pour les élèves de primaire de la ville qui y participent.

Ainsi, l’an dernier, un partenariat avec la médiathèque locale a amené un groupe à créer des outils de médiation numérique autour de l’album choisi dans le cadre du PEAC des écoles primaires de la ville, Os Court de J.-L. Fromental et J. Jolivet. Les élèves étaient chargés de créer des programmes sous Scratch permettant aux primaires de mieux comprendre le déroulement de cette enquête sur un voleur d’os dans une ville de squelettes pour en saisir le dénouement. Grâce au matériel disponible dans notre fablab enconstruction, ils ont pu utiliser des cartes makey-makey qui permettent par simple contact sur des matériaux conducteurs de déclencher des actions dans un programme. Le but était de réaliser un squelette interactif permettant au fur et à mesure de la lecture d’identifier les os volés pour comprendre que le voleur tentait de reconstituer un squelette entier. Sur le même principe, une variante squelette du Dr Maboul permettait de se placer du côté du voleur. Les élèves de Seconde ont eu ainsi à comprendre l’album, le scénariser, réaliser un programme de jeu pour chacun des deux outils, concevoir le produit final puis lors d’une visite au FabLab des Mines de Douai le réaliser. Le projet était complexe, demandait de nombreuses compétences et les élèves ont eu du mal à s’imaginer le résultat attendu. La visite de la directrice de la médiathèque a été un tournant conférant une réalité au projet, montrant qu’il suscitait une attente. A partir de là, deux conséquences sont apparues : certains élèves peu désireux de travailler ont baissé les bras alors que les autres, conscients qu’ils allaient réellement devoir présenter leurs outils de médiation à une dizaine de classes pendant deux jours, se sont investis dans la finalisation des outils. Le programme a été terminé par un élève en partie sur son temps personnel, d’autres ont commencé à câbler le squelette et le Dr Maboul en cours. L’appel à volontaires pour présenter pendant une demi-journée ce travail et faire la médiation auprès des scolaires à recueilli un accueil mitigé malgré l’insistance de la directrice de la médiathèque. En effet, les élèves ont eu peur de se lancer en public et il a fallu rassurer.

Les élèves qui ont participé au final n’étaient pas forcément les plus investis dans la réalisation mais ceux qui disposaient d’un réseau amical plus construit, avec une inscription en duo ou trio. Des conversations un an après avec ces élèves montrent bien le ressenti autour de cette position de médiateur : une très grande angoisse face à la responsabilité et la nécessité de se mettre en avant, et une satisfaction à l’avoir surmontée. Il est à noter que plusieurs d’entre eux sont maintenant délégués CDI.

Bibliobornes

Un autre exemple de ce ressenti a pu être constaté lors d’un projet en Première STMG où, toujours pour le salon PolarLens, il leur a été proposé de se constituer en mini-entreprise pour réaliser une borne interactive présentant des nouvelles de l’auteur invité au lycée, Jérôme Leroy. Cette activité a eu lieu en co-animation en AP avec un professeur d’éco-droit et un de français pour chacune des deux classes concernées. Chaque demi-classe devait concevoir une borne interactive à partir d’un cahier des charges qui leur donnait le public, l’usage, les dimensions maximales, le phasage du projet et la date de livraison pour le salon. Cette année-là, c’était un public particulièrement difficile et la mise au travail a été longue, les élèves ne croyant notamment pas à la réalité du projet et des sorties prévues dans ce cadre. Heureusement, dès les premières séances, quelques élèves se sont appropriés l’activité dans chacun des groupes, sauf un qui a été retiré du dispositif suite à un refus concerté de participer. Dans un autre groupe, il a fallu faire signer un « contrat de travail scolaire à durée déterminée » sur la base d’un CDD pour parvenir à engager leur responsabilité. Une fois cette première phase passée, et une fois les rôles répartis, un tiers de chaque groupe s’est pleinement investi dans le travail, tandis que les autres suivaient