C’est une réalité aujourd’hui, la new romance étiquetée aussi new adult fait lire les adolescents. Elle a ses éditeurs phares et ses titres repères, telles les sagas Twilight parue en 2008 et After en 2010. Publiée chez Hugo Publishing, After a été la première fanfiction issue de la plateforme collaborative d’écriture Wattpad à attirer l’attention de l’éditeur. C’est ce même éditeur qui en 2014 dépose la marque ©new romance, et c’est en 2015 que Cinquante nuances de Grey semble avoir désacralisé l’érotisme.

Alors que les pratiques de lecture des jeunes évoluent, et que les demandes d’achat des titres new romance explosent dans les bibliothèques, comment le professeur documentaliste peut-il exploiter ce courant littéraire afin de promouvoir la lecture dans les CDI ?

Mon article, au-delà d’une réflexion personnelle et d’une analyse de pratique dans un cadre professionnel, s’inspire de lectures, d’écoutes de podcasts, d’une interview faite dans le cadre du salon du livre de Tahiti le 20 octobre 20231 avec Jeanne Seignol, journaliste littéraire (@jeannotselivre), et d’un échange audio avec Marine Flour, responsable éditoriale de la new romance française chez Hugo Publishing, le 14 décembre 2023. J’ai aussi voulu m’appuyer sur les pratiques des élèves et à ce titre j’ai réalisé une courte enquête pour récolter leurs avis (143 réponses collectées au 22/12/2023).

Depuis le début de ma carrière professionnelle de professeur documentaliste, je constate qu’en termes de promotion de la lecture il y a peu d’entre-deux. Les élèves disent ne pas aimer lire ou sont des boulimiques de lecture et des fidèles habitués du CDI. Chacun est enfermé dans son biais cognitif de confirmation et les frontières paraissent peu perméables.

Pour autant, la première catégorie devient le public captif pour le cœur de métier du professeur documentaliste : amener le plus grand nombre à développer le goût et le plaisir de lire.

Beaucoup de méthodes et de moyens connus sont à la disposition des enseignants pour favoriser cette ambition et impulser une émulation (club lecture, lecture offerte, fonds manga, concours littéraire, rallye lecture…).

L’année scolaire 2022-2023 fut dans mes observations de pratiques de lecture adolescente une année charnière, surprenante et déterminante.

J’enseigne actuellement dans un lycée général, technologique et professionnel de 2070 élèves, dont 566 étudiants en zone urbaine2 de Polynésie française. Les taux de fréquentation et d’emprunts antérieurs à cette rentrée 2022 sont assez faibles : 14 % des élèves ont emprunté (statistiques BCDI) ; 2 173 entrées/trafic moyen par jour : 159 élèves ; moyenne de 15 élèves par heure (statistiques CDIstat) au bilan de juin 2021.

Les élèves sont issus de catégories socio-professionnelles défavorisées et les chiffres sont sans appel : lors de la journée défense et citoyenneté, un test de l’Éducation nationale, élaboré en 2015, signale qu’entre 38 et 42 % des jeunes sont en situation d’illettrisme en Polynésie française, contre 10 % en métropole3 ; en 2019, les résultats montrent que 21 % ne maîtrisent ni la lecture, ni l’écriture, contre 7 % dans l’Hexagone4.

Madame je n’aime pas lire,

Maman je n’aime pas lire

Les élèves n’aiment pas lire, c’est ce qu’ils disent, c’est ce qu’ils croient.

Ma fille, lycéenne également, qui a écouté une histoire chaque soir pendant les douze premières années de sa vie, qui est entourée de livres chez elle, qui observe sa mère lire en permanence, n’aime pas lire, c’est ce qu’elle dit, c’est ce qu’elle croit, dans tous les cas : elle n’a jamais lu de manière volontaire des lectures plaisir et pour ces jeunes, la lecture est souvent porteuse de multiples représentations d’activités scolaires.

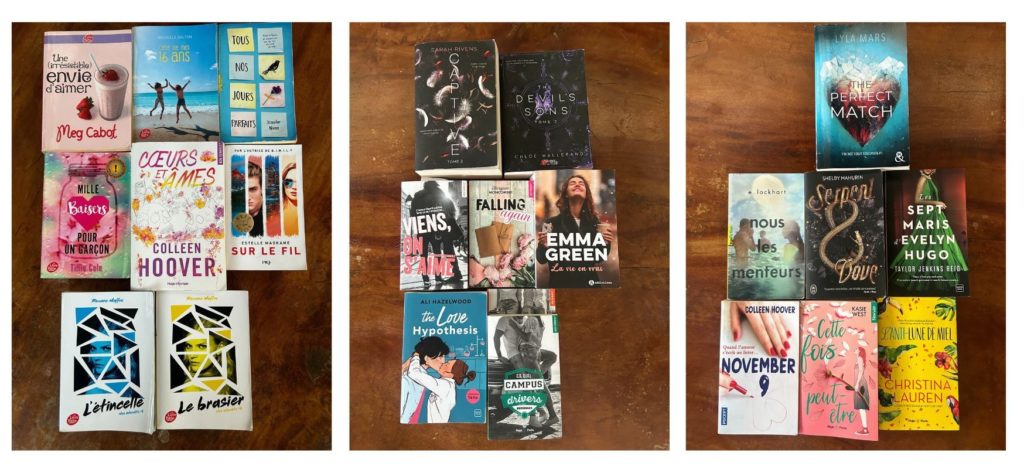

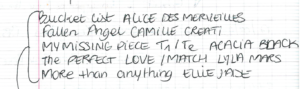

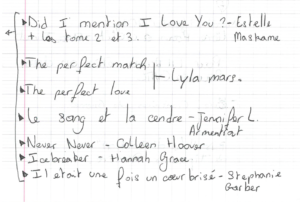

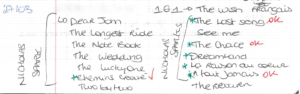

Or, quelques semaines après la rentrée scolaire d’août 2022, le cahier de suggestions du CDI et la bibliothèque de ma fille ont commencé rapidement à se remplir de titres de new romance.

Je me suis donc interrogée sur ce qui a engendré cette (r)évolution si radicale : quels sont les critères qui déclenchent chez beaucoup d’adolescents ce plaisir de lecture ?

Définition et historique de la new romance

Au fil des échanges informels avec mes collègues professeurs documentalistes lors de l’écriture de cet article, j’ai pu faire le constat que beaucoup ignorent à quoi correspond ce genre, sa définition, ses auteurs phares, les titres plébiscités et ses enjeux. Parmi les raisons avancées pour ne pas faire l’acquisition de ce genre de romans, est souvent invoquée, à côté de la question des représentations filles-garçons qu’il véhicule, la méconnaissance du genre.

Babelio définit le new adult comme :

« […] un genre de roman dans lequel les personnages principaux ont entre 18 et 30 ans. Le terme a été créé […] pour désigner des œuvres similaires mais qui puissent être proposées également à des adultes. Ce sous-genre se focalise sur des thèmes tels que le départ du foyer familial, le développement de la sexualité et la confrontation aux choix de carrières, thèmes qui touchent ces jeunes adultes5. »

Ambre Rouvière, responsable éditoriale littérature aux éditions Prisma, parle d’« une histoire d’amour avec des codes adolescents dans laquelle on trouve des scènes de sexe explicites6 ». Marine Flour, de son côté, distingue « trois éléments essentiels » :

« raconter une histoire d’amour (point central de l’intrigue), interroger le monde actuel (ancrage contemporain), avoir une fin heureuse (pacte narratif entre le lecteur et l’auteur). En parallèle, les scènes de sexe sont explicites si l’histoire le justifie et si l’auteur le souhaite, en aucun cas c’est une obligation. » (Entretien, 14 décembre 2023.)

Le concept de new romance (NR) est une marque déposée en 2014 par Hugues de Saint-Vincent, fondateur de la maison d’édition indépendante Hugo Publishing7 et qui s’est spécialisée dans cette part de marché, largement dominée par les femmes (lectrices et auteures) (92 % des répondants de notre enquête sont d’ailleurs des filles.) Comme le remarque Marine Flour à propos du lectorat type actuel, « 90 % de femmes ont entre 15 et 25 ans avec une transmission de mères en filles […] néanmoins, depuis deux ou trois ans, on voit arriver de plus en plus de garçons à la lecture de romances, ce qui est un super signal sur l’évolution de la société ». (Entretien, 14 décembre 2023.)

La maison d’édition a vu son chiffre d’affaires progresser de 90 % entre 2014 et 2015.

De Beautiful Bastard, de Christina Lauren (2013) et After, d’Anna Todd (2015), à Calendar Girl, d’Audrey Carlan (2018), en passant par les séries Driven de K. Bromberg, The Elements, de Brittainy C. Cherry ou les romans de Morgane Moncomble et de Gaïa Alexia, une longue liste de best-sellers a permis à Hugo Roman de devenir un des tous premiers éditeurs de littérature générale en France. Le monde de la new romance, importé des États-Unis, est truffé d’anglicismes.

Robert Laffont a lancé un concours de manuscrits de premier roman sur TikTok ; et Hugo Publishing a également développé Fyctia en 2015, sa propre plateforme numérique gratuite d’écriture et de lecture de new romance, romantasy, comédie romantique et thriller, avec l’idée de proposer un nouveau rapport entre auteurs, éditeurs et lecteurs. À travers des concours, l’éditeur peut rapidement repérer de jeunes auteurs prometteurs tout en évitant la lourdeur et la lenteur du circuit éditorial et des comités de lecture habituels. En quelques années, plus de 150 textes ont ainsi été publiés par une soixantaine d’auteurs.

Enfin, depuis sept ans maintenant, ce même éditeur organise le festival de new romance8 qui affiche complet de longues semaines avant (3500 billets vendus en 24 h pour l’édition 2023). Pour l’édition 2023 à Strasbourg, étaient présents pas moins de 34 auteurs et 600 références dans la librairie dédiée (le panier moyen est de 110 € et souvent l’objet des dépenses du pass Culture).

« Avec la ‘Young adult’, on va être plus sur quelque chose de soft, de sweat », explique en 2017 Sophie Lagriffol, responsable éditoriale pôle féminin chez Harper Collins France ;

« Sur la ‘New adult’, on est sur un cahier des charges différent, avec des sujets plus ancrés dans le réel, avec des histoires d’amour plus intenses, plus engagées. L’action va se situer dans le monde professionnel ou à l’université. Et la grosse différence, c’est le sexe, qui va être beaucoup plus présent. »

« Mais les auteurs n’écrivent pas sur commande, en suivant un cahier des charges. Ils écrivent librement, et ensuite, c’est notre travail d’éditeur de savoir à quel cœur de cible le roman s’adresse […] Là on essaie de lancer un nouveau concept, la ‘Dark romance’, où l’on monte encore en intensité, avec des histoires de manipulations, de vengeances, des histoires avec une charge émotionnelle encore plus forte. »

La romance existe depuis toujours, la collection Harlequin est implantée en France depuis maintenant 45 ans. La plateforme wattpad a démocratisé et dédramatisé ce genre considéré comme « sous genre » par opposition à la littérature dite classique.

Augustin Trapenard, journaliste et présentateur de La Grande Librairie, déclare à ce propos, dans le documentaire de Jeanne Seignol Comment Tiktok bouleverse l’industrie du livre ? (Jeannot se livre, 20239) :

« Le bon goût littéraire, si on le définit, on se pose la question de savoir d’où il vient, en réalité cela a quelque chose à voir avec une culture élitiste. Cette façon d’envisager la littérature est violente car excluante. » (Trapenard, 2023)

La moitié des livres vendus en librairie sont des mangas, et l’éditeur star de la new romance a fait 42 millions de chiffre d’affaires en 2022. La création du pass Culture en 2021 permet également aux jeunes de dépenser jusqu’à 300 € en biens culturels et de démocratiser la romance. Peu à peu les médias mainstream, comme par exemple Le Monde, France Inter, France Culture, Lire, La Grande Librairie s’emparent de ce genre, reconnaissent et légitiment ainsi ce lectorat souvent marginalisé.

La responsabilité et la démarche pédagogique des éditeurs

L’explosion du lectorat s’est faite en parallèle du développement du réseau social TikTok et est devenue un phénomène de mode utilisé largement par les maisons d’édition.

Les éditeurs ne s’y sont pas trompés et s’engouffrent dans la démarche commerciale de ce marché porteur et de ce public captif. Beaucoup de maisons d’édition ont dorénavant leur collection sentimentale ; là encore pour se différencier, elles rivalisent d’imagination pour proposer des dénominations originales de catégories (new way, stardust, comédie romantique, drame psychologique, érotique, romance psychologique, dark romance, new romance, new adult, romantasy, romantic suspens…), de thématiques ou même encore pour avertir le lecteur des degrés d’intensité de sexualité.

Ces collections s’appellent, entre autres, « Adult Romance » chez Addictives, « &moi » chez Lattès, « Red Velvet » chez Marabout ou encore « Best » chez J’ai lu pour elle. L’on peut d’ailleurs s’interroger sur les choix éditoriaux, notamment des couvertures, en guise d’avertissement de contenu. La couverture de The Love Hypothesis d’Hali Hazelwood, un conte sentimental dans un environnement professionnel, est enfantine, et pour autant, le chapitre 16 est entièrement dédié à la description explicite et érotique d’une scène d’amour. Arthur de Saint Vincent de chez Hugo reconnaît dans un article de Libération du 10 juin 202310 : « Certaines de nos couvertures ont pu être trop axées jeunesse et tromper les lecteurs mais nous avons mis en place un système très clair pour les limites d’âge ». Il revient également aux libraires de ranger les livres dans les bons rayons et d’expliquer aux lecteurs mais aussi aux parents que certains romans peuvent contenir des propos choquants. Dans le monde du livre, l’idée d’adosser un système d’évaluation tel que PEGI pour les jeux vidéo est en discussion depuis de nombreuses années, les trigger warnings (TW : avertissements) fleurissent dorénavant. En effet, pour guider le choix des lectures adolescentes, les éditeurs commencent à associer à leur objectif commercial une démarche pédagogique.

Tout récemment, chez Hugo Publishing, sur un titre paru en janvier 2024, est apposée et clairement identifiée en couverture la mention : « Ce livre est une dark romance destinée à un public averti. »

De même, le dernier roman de Morgane Moncomble, Un automne pour te pardonner, contient un avertissement en ouverture :

« Ce roman contient des scènes, des propos ou des sujets pouvant heurter la sensibilité de certaines personnes. S’il vous plaît, prenez garde au trigger warning* qui suit avant de vous aventurer dans cette lecture. Je tiens également à rappeler qu’il s’agit d’une œuvre de fiction ; avec des personnages imparfaits, des relations pas toujours saines et des comportements parfois inexcusables. L’autrice et la personne que je suis ne cautionne en rien les actes de ses personnages. *TW : harcèlement psychologique, bizutage. »

Les jeunes, souvent bien isolés face au foisonnement des rayonnages, peuvent se sentir démunis. Et les parents sans doute encore plus. C’est dans ce contexte, que TikTok se positionne clairement comme le premier support de recommandation de lectures et de new romance plus particulièrement.

Les facteurs du succès de la new romance

En premier lieu, s’identifier : les personnages ont l’âge des lecteurs (et souvent sensiblement le même que les auteurs d’ailleurs). « C’est un genre qui est écrit à 80 % à la première personne et au présent, on fait vivre une histoire au lecteur (technique du Show don’t Tell11) et on incarne le héros », confirme Marine Flour (entretien, 2023).

En second lieu, appartenir à une communauté : sortir de l’isolement spécifique de la lecture, activité par essence solitaire ; pouvoir partager les émotions de sa lecture avec ses pairs est particulièrement vrai pour la new romance, le succès du festival new romance témoigne du besoin pour chaque lecteur de se retrouver et d’échanger sur ces expériences de lecture. Cette communauté se retrouve au sein des CDI dans les transmissions de conseils, les retours de lectures et la viralité des prêts.

En troisième lieu, vivre l’amour. La trame narrative essentielle se tisse autour des romances et du sexe, et se termine en happy end. 86 % des répondants expliquent que c’est ce qui leur plaît le plus. Rêver d’amour en étant adolescent est fondateur de son développement affectif.

En dernier lieu, la construction de soi : avec des sujets ancrés dans le réel, dans des univers de femmes contemporaines et exploitant des faits de société. La psychologie de l’adolescent avec des questions qui lui sont propres est souvent traitée : qui suis-je ? Qui voudrais-je être ? Quels sont mes choix existentiels ? C’est aussi une littérature qui ne se cantonne pas à un seul genre, on y trouve du fantastique (romantasy), du réalisme, de la mythologie, de la romance, du suspens et même des dystopies. La lecture est pour beaucoup une façon de s’échapper, de se donner à vivre autre chose.

Des pratiques de lecture diversifiées

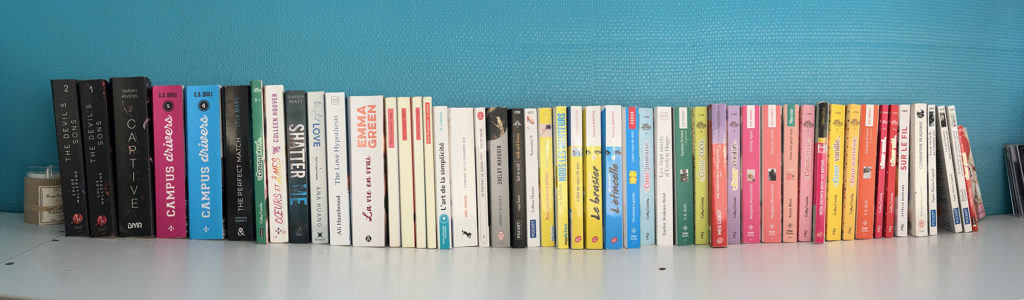

Par le biais de demandes réitérées d’achats au CDI, je me suis aperçue que les élèves lisent bien plus qu’il n’y paraît. Au CDI, les élèves qui conseillent des livres les ont en majorité déjà lus et les ont souvent déjà à la maison. C’est assez touchant de voir que dans une démarche altruiste, ils souhaitent faire profiter les autres usagers de leurs recommandations et de leurs lectures plaisirs. Un vrai trafic de prêts entre copines s’organise pour être de celles qui auront lu le nouveau tome en premier ; une organisation se fait entre celle qui achètera le premier et celle qui se procurera le suivant d’une série (par exemple Campus driver). Comme le démontre Jeanne Seignol dans son documentaire Vraiment, les jeunes ne lisent plus ? (18 novembre 2022), les adolescents lisent, mais ne sont parfois pas des emprunteurs des CDI, d’où la difficulté pour les professeurs documentalistes à les identifier et à les capter. À ce titre, 74 % des répondants de l’enquête disent acheter leur propre roman de new romance (parents ou cadeaux). Marine Flour remarque également de manière intéressante que ces lecteurs sont :

« des lecteurs avertis (qui fréquentent les comptes de recommandations) et qui savent ce qu’ils veulent. Au final, sur le festival de new romance, on est amené à faire peu de conseils car on est sur des lecteurs qui savent ce qu’ils viennent chercher. Le premier conseil pour accompagner le lectorat est de l’écouter car on est face à des connaisseurs et un public qui est capable de lire un livre par jour. » (entretien, 2023).

C’est le rôle du professeur documentaliste d’être dans la médiation de ce type de littérature. Il paraît important de contextualiser un texte, comme on l’a vu précédemment avec une nécessité de la part de l’éditeur et du libraire, voire de l’auteur, de verbaliser ce à quoi on doit s’attendre « un texte cela peut être émancipateur mais cela peut aussi faire mal » (Augustin Trapenard, Octobre 2023). La new romance semble pour beaucoup de jeunes une entrée dans la lecture plaisir. Les modes et les genres évoluent : aux professeurs documentalistes de s’informer et d’exploiter cette nouvelle tendance. Dans ma propre pratique de lecture, je n’en exclus aucune, et je lis surtout ce que les élèves lisent et aiment car j’estime que cela fait partie de mes missions pédagogiques et éducatives. C’est la porte d’entrée sur un accord tacite de coopération entre adulte et adolescent, entre enseignant et élève. Car c’est un langage commun qui permet d’ouvrir le débat et d’aborder vraiment les questions de sens, de choix et de sujets de société. Au moment de la diffusion de l’enquête auprès des élèves j’ai eu quelques retours très prudents « madame c’est fait pour boycotter la new romance dans les CDI ? ». Dans le cheminement d’un élève, il semble que le CDI espace du livre dans l’établissement, est assez éloigné, par son contenu, de la bibliothèque idéale d’un adolescent. Ce qui est confirmé par les chiffres : seulement 18 % des répondants à l’enquête estiment que c’est le CDI qui leur a donné envie de lire ce type de romans.

La new romance comme vecteur pédagogique

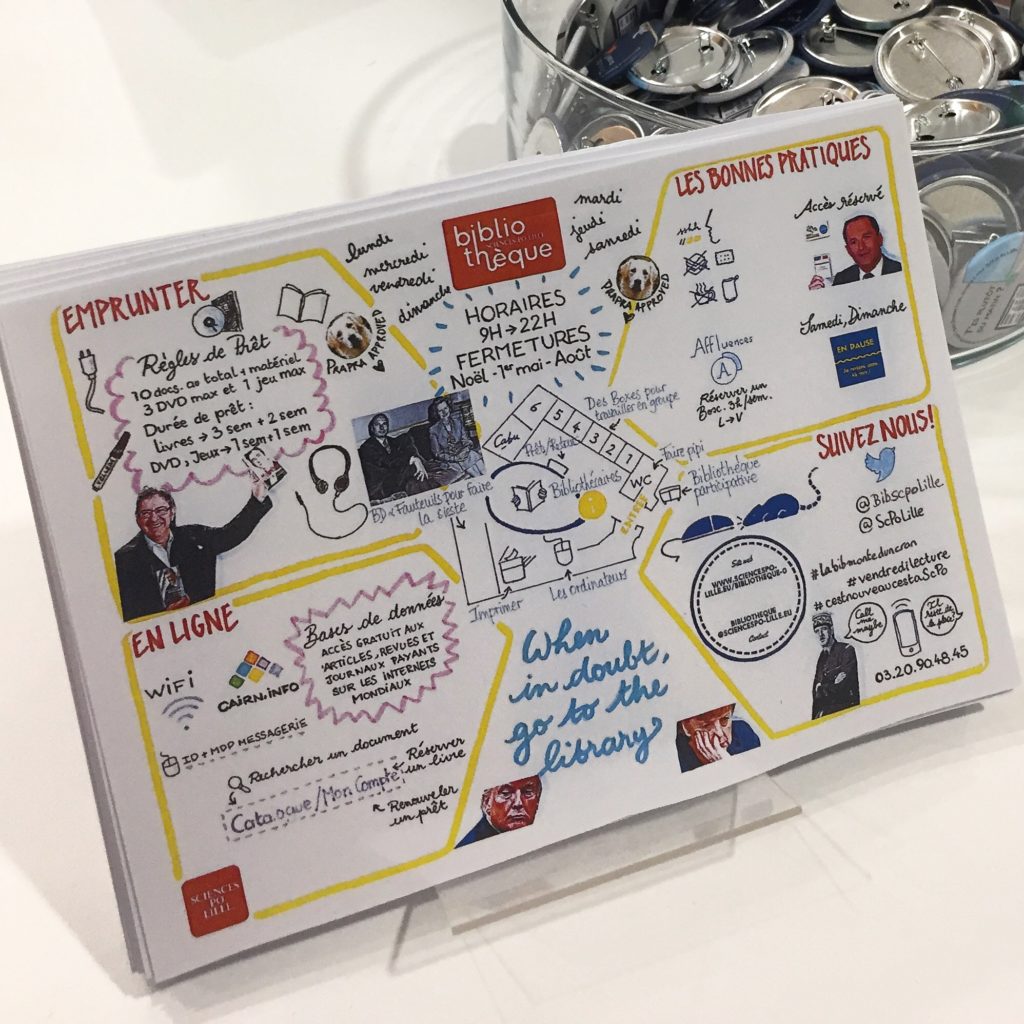

De manière non exhaustive, voici quelques initiatives pédagogiques qui peuvent permettre d’accompagner les différentes acquisitions de new romance en CDI. Dans un premier temps, il paraît prudent d’être critique par rapport aux propositions faites notamment par le biais du cahier de suggestions ou devant des demandes parfois insistantes : c’est à ce moment-là qu’un premier dialogue peut être entamé sur les motivations du choix des lectrices. Comment connaissent-elles ces titres ? Est-ce qu’elles les ont déjà lus ? Pourquoi les ont-elles aimés ? Peuvent-elles raconter l’histoire ?

Faire des unboxing peut être pertinent à l’arrivée des commandes ; à cette étape, cela permet d’attiser la curiosité pour d’autres romans. Comme plus tard, associer les élèves aux étapes de catalogage et d’équipement. L’incidence est immédiate : les réservations en ligne sur e-sidoc se multiplient, fonction qui permet de faire quelques rappels de méthodologie de recherche.

La lecture de new romance peut également être une porte d’entrée vers la littérature en langue originale : par exemple, il est relativement facile de faire lire des titres de Colleen Hoover en anglais, l’argument fort étant de pouvoir lire les nouveautés en avant-première. La saga Harry Potter a largement bénéficié de ce phénomène qui démultiplie l’effet d’attente chez les lecteurs.

De plus, certains sujets (notamment la mythologie) peuvent être explorés de façon moins conventionnelle. Certains classiques littéraires ou auteurs cités dans des new romances voient leur vente augmenter (Les Hauts de Hurlevent, Orgueils et préjugés, Oscar Wilde…) et emmènent des lecteurs à la découverte d’autres auteurs. Des pratiques pédagogiques plus ordinaires peuvent aussi fédérer autour de ce genre : inviter les élèves à créer leurs propres recommandations grâce à des booktube, booktrailer ou des booktok. Maelly et Dieunie, deux élèves du lycée Félix Eboué de Cayenne, ont rédigé un article dans le journal de leur établissement sur BookTok12. On peut également apposer sur les ouvrages des avertissements rédigés par les élèves. Dans tous les cas, j’échange au moment du prêt et du retour. Ce qui me paraît être une nécessité professionnelle est également de lire quelques titres plébiscités afin d’établir un contact avec les lecteurs du CDI.

Toutes ces initiatives pédagogiques ont eu un effet stimulant sur le taux d’emprunt : + 85 % sur le bilan du CDI de juin 2023 (corrélé à + 51 % en taux de fréquentation).

Enjeux et limites de la new romance

De ces dialogues, naissent régulièrement des discussions autour de sujets qui touchent les valeurs des jeunes, et qui sont objet de débats dans la société. Selon les résultats de l’enquête, 57 % des répondants sont parfois choqués de l’image de la femme dans ces romans (38 % ne le sont pas), 46 % verbalisent la nécessité d’échanger sur l’absence de valeurs morales, 39 % sur la violence. Le plaisir de lire demeure néanmoins le plus fort pour poursuivre ces lectures (80 % des répondants). L’on peut envisager un club lecture thématique avec la présence d’un infirmier scolaire, des actions autour des violences intrafamiliales avec des professionnels, des jeux de rôle ou bien des débats. Toute initiative pédagogique permettant d’aborder ces sujets sensibles est la bienvenue. Le professeur documentaliste tend à devenir le médiateur d’une réflexion en construction : parler plutôt que censurer, alerter plutôt que dramatiser, partager plutôt que culpabiliser. D’autant que la bienséance des adultes ne résiste souvent pas à l’authenticité et à la lucidité des adolescents : les craintes des adultes ne sont pas toujours justifiées. L’érotisme et la sexualité arrivent en dernier des thèmes qui heurtent les élèves (20 % des répondants). Un lectorat adulte (sauf cas particulier) prendra note des sujets abordés et aura conscience de la limite entre fiction et réalité. Les adultes ont tendance parfois à infantiliser les élèves, à les déresponsabiliser alors qu’eux-mêmes ne sont pas dupes des enjeux thématiques : le prix Goncourt des lycéens 2023 (Triste tigre de Neige Sinno) témoigne de la lucidité et de la maturité des élèves. La récente (2019) collection l’Ardeur de Thierry Magnier, destinée « aux plus de 15 ans, [qui publie] des ouvrages [qui] parlent de sexualité d’une manière heureuse, aux antipodes d’un porno trop souvent vu comme une norme par les ados » témoigne du besoin « d’une littérature courageuse qui s’intéresse à l’adolescence telle qu’elle est, avec ses zones d’ombres, ses excès, ses émotions exacerbées. Mais l’adolescence est aussi une période où le corps se métamorphose, où la vie sexuelle commence. Quoi de plus logique, alors, que d’ouvrir [le] catalogue à des textes qui parlent de sexualité, de désir, de fantasme. L’Ardeur se pose résolument du côté du plaisir et de l’exploration libre et multiple que nous offrent nos corps13 ».

Apprivoiser la sexualité

La spécificité de la new romance étant d’intégrer des scènes explicites de sexe dans les romans, une question se pose : comment aborder la sexualité en établissement scolaire et dans les CDI ? Deux Thèmalire (« Sexualité et littérature ado », InterCDI, mai-juin 2020, n° 285 ; et « Les premières fois », InterCDI, mai-juin 2024, n° 306) ont exploré les différents enjeux de ces questions et proposé des ressources à exploiter au CDI.

À l’heure où en décembre 2023, un réseau comme Parents vigilants (affilié au parti d’extrême-droite Reconquête !) commence à infiltrer l’école et remet en cause l’éducation sexuelle en classe (preuve en est la pression exercée pour retirer des livres sur la sexualité des CDI, l’association obtenant gain de cause dans un établissement privé catholique), le CDI, en tant que lieu de ressources des multiples éducations, se doit d’être le garant de la transmission des valeurs de respect, de tolérance et de consentement, adaptée à chaque public, à chaque sensibilité et à chaque âge. S’il paraît communément admis de proposer des documentaires sur la sexualité en rayon psychologie, sociologie et/ou santé, et d’aborder la sexualité sous un angle éducatif, il est parfois plus difficile de consentir à des fictions intégrant des scènes érotiques pouvant amener l’adolescent à découvrir et expérimenter son désir et sa sexualité différemment que sur internet.

La censure de l’ouvrage Bien trop petit de Manu Causse en juillet 2023 soulève des enjeux bien plus importants que ceux que l’on avance officiellement : l’hypocrisie d’une frange de la société puritaine, le lobbying de courants radicaux, la censure infondée, l’infantilisation des lecteurs et des adolescents, la remise en question des engagements personnels des auteurs. D’autant que l’éditeur Thierry Magnier a pris soin en quatrième de couverture d’apposer un bandeau d’avertissement : « Puisqu’il présente des scènes explicites, nous avons pris soin de faire figurer sur la 4e de couverture une mention adressant ce livre à un lectorat averti, à partir de 15 ans ». Pour justifier cette censure le ministre s’appuie notamment sur la loi de 1949 (sur les publications destinées à la jeunesse) toujours en vigueur et qui est de toute évidence obsolète face à l’évolution de ces questions et les pratiques de lectures adolescentes.

livre à un lectorat averti, à partir de 15 ans ». Pour justifier cette censure le ministre s’appuie notamment sur la loi de 1949 (sur les publications destinées à la jeunesse) toujours en vigueur et qui est de toute évidence obsolète face à l’évolution de ces questions et les pratiques de lectures adolescentes.

La nouveauté dans les premières new romance est l’affranchissement du modèle patriarcal, par exemple Sex and the city (2002) et Le journal de Bridget Jones (2004) mettent en scène pour la première fois des trentenaires célibataires qui assument leurs désirs. Dans le dernier ouvrage paru en 2023 de Morgane Moncomble Seasons, tome 1 : Un automne pour te pardonner, l’évolution de la relation amoureuse (même si elle démarre sur un trope “ennemies to lovers” : sentiment de haine par l’héroïne envers le garçon qu’elle finira par aimer) et les scènes de sexe (chapitres 20, 25 et 28) sont toujours empreintes de consentement et de décence.

Pour autant, la journaliste et auteure Camille Emmanuelle, dénonce dans une interview :

« la manière dont les maisons d’édition ont fait de ce genre littéraire un produit marketing extrêmement codifié : normalisation des rôles féminin et masculin, sexualité aseptisée, noms américains, règne absolu du ‘glamour’ […] Ce qui paraît intéressant dans la littérature érotique est bien en ce qu’elle n’est jamais traumatisante. Les images peuvent l’être : on peut tomber sur une vidéo pornographique par hasard, sans y être préparé. Face à un texte, le rapport est très différent. On peut fermer le livre très vite, passer les pages et les lignes. Chaque lecteur a ses propres filtres mentaux qui empêchent le contenu de devenir intrusif. Je milite pour que ce genre de textes soit davantage connu, car il montre qu’en dehors des codes de YouPorn et de la romance, une autre vision du couple et de la sexualité est possible. » (La romance décomplexée, Emmanuelle Camille, juin 201714).

Autant de questions à explorer dans le dialogue construit avec les élèves. Des projets concertés avec les services éducatifs, sociaux et médicaux des établissements peuvent permettre aux élèves de continuer à libérer la parole et œuvrer à leur bien-être. Le succès de la série Sex Education sur Netflix est représentatif d’une génération plus assumée dans sa sexualité et dans son identité de genre. Dans un pays comme la France, où ce sujet reste encore tabou, offrir des ressources aux élèves leur permettant de dépasser les stéréotypes, de construire leur identité sexuelle dans la bienveillance, d’aborder des problèmes affectifs inhérents à l’adolescence et d’amorcer le dialogue sur leurs préoccupations semble fortement recommandé.

C’est un poncif de se dire que la littérature doit donner à explorer les sujets sensibles de la société mais qu’elle doit aussi nous pousser à une réflexion sur le monde et sur nous-mêmes. La new romance n’échappe pas à cet objectif et le rôle de médiateur et de facilitateur de lectures du professeur documentaliste s’applique aussi aux appétences des élèves et aux modes éditoriales.

Pour conclure

Le désir semble être un des derniers tabous de la littérature de jeunesse alors même que cette génération d’adolescents grandit avec une évolution positive des représentations et l’accès facilité à l’information sur la sensualité, le consentement, les genres…

Pour autant des stéréotypes de relation hétéronormée parfois non équilibrée persistent dans cette littérature en vogue qu’est la new romance. Ce genre est codé, au point d’être un secteur qui s’auto-alimente avec des couvertures, des scénarios et des personnages quasiment interchangeables et qui devient un pur produit marketing. La romance est en train de devenir un domaine stratégique pour l’édition. Scarlett St. Clair et Morgane Moncomble figurent dans les 18 meilleurs auteurs français en vente cumulée et Colleen Hoover, côté romans étrangers. Signe d’une évolution de la perception de ce genre déconsidéré, le patron des éditions du Seuil a annoncé en 2023 la création d’un « espace dédié aux littératures de genre grand public », tout comme Editis qui a créé Chatterley, « une maison d’édition dédiée à la romance adulte ». Si les éditeurs s’engouffrent dans cette nouvelle part de marché, c’est bien parce que les réseaux sociaux et les communautés #booktok #booktube #bookstagram propulsent ces histoires en tête des lectures des « jeunes adultes ». Cet enthousiasme profite à bon nombre d’adolescents qui se sont vus devenir lecteurs et qui découvrent à leur tour la magie de la lecture plaisir et le transport de l’âme à travers de vastes imaginaires et de puissantes émotions.

De nombreux sujets afférents pourraient faire l’objet de développements approfondis et auraient leur intérêt dans la stimulation intellectuelle qu’offrent les articles professionnels. La féminisation du genre, la réception de la romance chez les adolescents, les spécificités de la dark romance et leurs sombres attraits, les plateformes d’écriture, l’égalité filles-garçons, la prescription TikTok… restent encore à explorer.

Il n’en demeure pas moins une perpétuelle question, à savoir qui de l’éditeur ou du lecteur fait le succès d’un titre ? Les plateformes d’écriture et les réseaux sociaux ont tendance à bouleverser les principes établis mais les éditeurs ont rapidement saisi les occasions et replacé au centre du débat l’enjeu financier de l’édition. Pour autant, les librairies, les bibliothèques et les CDI devraient encore bénéficier dans les prochains mois des retombées positives de l’appétit vorace de ces lecteurs. À chaque professionnel de se saisir de cette occasion. Ce qui compte c’est que le CDI puisse être un lieu de référence dans la lecture plaisir et le professeur documentaliste un guide dans les choix et les enjeux de la new romance. Être présent de manière concomitante et synchrone au besoin de l’élève est un beau défi éducatif. Tout comme le signifiait Jeanne Seignol lors de notre rencontre, « s’il y a des jeunes filles qui sont suffisamment en confiance pour venir faire ces demandes, c’est bon signe ». L’enjeu étant de pouvoir ouvrir et diversifier les possibles de lectures des élèves et faire acte de curiosité au-delà de l’algorithme de recommandation.

Cet été, dans votre PAL ajoutez un Colleen Hoover ou un Morgane Moncomble, vous serez peut-être surpris d’apprécier. Et sans doute qu’à la rentrée des classes, les élèves auront découvert un autre genre et rempliront le cahier de suggestions d’auteurs dont les professeurs documentalistes n’auront pas encore entendu parler.

Références Biblio-sitographiques

Béja, Alice. La new romance et ses nuances. Marché littéraire, sexualité imaginaire et condition féminine. Revue du Crieur, 2019, vol. 12, n° 1, p. 106-121. https://www.cairn.info/revue-du-crieur-2019-1-page-106.htm

Bigey, Magali. 50 nuances de Grey : du phénomène à sa réception. Hermès, La Revue, 2014, n° 69, p. 88-90. https://doi.org/10.3917/herm.069.0088

Bouhadjera, Hocine. Roman censuré : la sexualité interdite en littérature jeunesse ? Actualitté, Les Univers du livre, 19 juillet 2023. https://actualitte.com/article/112717/droit-justice/roman-censure-la-sexualite-interdite-en-litterature-jeunesse

Gary, Nicolas. Les 10 livres les plus vendus et les auteurs favoris des Français en 2023. Actualitté, Les Univers du livre, 27 décembre 2023. https://actualitte.com/article/114930/meilleures-ventes/les-10-livres-les-plus-vendus-et-les-auteurs-favoris-des-francais-en-2023

Hakem, Tewfik, Vassy, Marceau & Abouchar, Vincent. La Romance par Blutch et Morgane Moncomble, ou le renouveau d’un genre. France Culture, 20 novembre 2022. https://www.radiofrance.fr/france

culture/podcasts/affinites-culturelles/la-romance-par-blutch-et-morgane-moncomble-ou-le-renouveau-d-un-genre-6297252

Hamou Aldja, Inas. Le phénomène de la «New Romance» : le genre littéraire qui fait exploser les ventes en France. France Info, 10 novembre 2023. https://www.francetvinfo.fr/culture/livres/roman/le-phenomene-de-la-new-romance-soit-la-romance-actuelle-le-genre-litteraire-qui-explose-les-ventes-en-france_6167226.html

Houot, Laurence. «Young adult», «Dark romance», «New adult» : littérature ou marketing ? Enquête au salon Livre Paris. France Info, 26 mars 2017. https://www.francetvinfo.fr/culture/livres/roman/quot-young-adultquot-quot-dark-romancequot-quot-new-adultquot-litterature-ou-marketing-enquete-au-salon-livre-paris_3363159.html

La romance décomplexée (dossier). Lecture Jeune, juin 2017, n° 162. https://ww.lecturejeunesse.org/product/la-romance-decomplexee-n162-juin-2017/

Paradis, Josée-Anne. La « new romance » sous la loupe : un phénomène plus grand que nature. Les libraires, 7 avril 2017. https://revue.leslibraires.ca/articles/litterature-etrangere/la-new-romance-sous-la-loupe-un-phenomene-plus-grand-que-nature/

Pourquoi parler d’amour et de sexualité dans la littérature jeunesse ? France Culture, 27 novembre 2023. https://www.radiofrance.fr/franceculture/podcasts/etre-et-savoir/pourquoi-parler-d-amour-et-de-sexualite-dans-la-litterature-jeunesse-1602609

Rom’com, new romance : le girl power de l’édition ? France Inter, 28 novembre 2017. https://www.radiofrance.fr/franceinter/podcasts/le-nouveau-rendez-vous/rom-com-new-romance-le-girl-power-de-l-edition-7387017

Seignol, Jeanne. Jeannot se livre : Comment Tiktok bouleverse l’industrie du livre ? Youtube, 25 mars 2023. https://www.youtube.com/watch?v=H13SZ1j3bLM&t=2s

Seignol, Jeanne. Jeannot se livre : envoyée spéciale du booktube game. France Culture, 19 septembre 2023. https://www.radiofrance.fr/franceculture/podcasts/lectures-numeriques/jeannot-se-livre-envoyee-speciale-du-booktube-game-9907311

Servos, Marie-Stéphanie & Djoupa, Aïda. Le BookClub Mad : romance et féminisme, un amour impossible ? Youtube, 2 mars 2023. https://youtu.be/JK9rYBwrd_U?si=uRMDV5Ikoei2TFxx

Van der Linden, Sophie. Sexe et ados : que peut la littérature ? Libération, 30 novembre 2021. https://www.liberation.fr/culture/livres/sexe-et-ados-que-peut-la-litterature-20211130_EULQLXUBSFDLFGUFIJTK7CSCRI/

Références complémentaires

Collection l’Ardeur. Editions Thierry Magnier, s.d. https://www.editions-thierry-magnier.com/collection-l-ardeur-1237.htm

Dansoko Touré, Katia. La littérature érotique fait sa mise à jouir. Libération, 5 février 2023. https://www.liberation.fr/lifestyle/la-litterature-erotique-fait-sa-mise-a-jouir-20230205_JSZDUWSM7

ZH5TNL3IRZLTLFBKE

Durand, Marine. Dossier Romance : le coming out. Livres Hebdo, 5 février 2016. https://www.livreshebdo.fr/article/dossier-romance-le-coming-out

Goldszal, Clémentine. Lire en VO, une tendance en hausse chez les ados. Le Monde, 16 septembre 2023. https://www.lemonde.fr/m-le-mag/article/2023/09/16/lire-en-vo-une-tendance-en-hausse-chez-les-ados_6189697_4500055.html

Goldszal, Clémentine. La new romance, filon à l’eau de rose du monde de l’édition. Le Monde, 11 novembre 2023. https://www.lemonde.fr/m-le-mag/article/2023/11/11/la-new-romance-filon-a-l-eau-de-rose-du-monde-de-l-edition_6199498_4500055.html

Jiji & Célia. New(s) Romance. L’émission 100 % NR. Youtube. NewRomanceChannel, février 2023. https://www.youtube.com/@NewRomanceChannel

Johannès, Franck. À Tahiti, l’envers sombre du paradis touristique. Le Monde, 17 avril 2023. https://www.lemonde.fr/idees/article/2023/04/17/a-tahiti-l-envers-sombre-du-paradis-touristi

que_6169799_3232.html

Moreau, Willy. « Il y a des scènes de sexe très explicites » : l’embarras des éditeurs et libraires face au succès des « dark romances », un nouveau genre littéraire. France Info, 19 avril 2023. https://www.francetvinfo.fr/culture/livres/reportage-il-y-a-des-scenes-de-sexe-tres-explicites-l-embarras-des-editeurs-et-libraires-face-au-succes-des-dark-romances-un-nouveau-genre-litteraire_5778326.html

Oury, Antoine. Jeannot se livre : « On ne lit plus maintenant comme on lisait hier ». Actualitté, Les univers du livre, 21 novembre 2022. https://actualitte.com/article/108789/trouvailles/jeannot-se-livre-on-ne-lit-plus-maintenant-comme-on-lisait-hier

Seignol, Jeanne. Jeannot se livre : Vraiment, les jeunes ne lisent plus ? (Documentaire). Youtube, 19 novembre 2022. https://www.youtube.com/watch?v=FLDuKeKDDZU